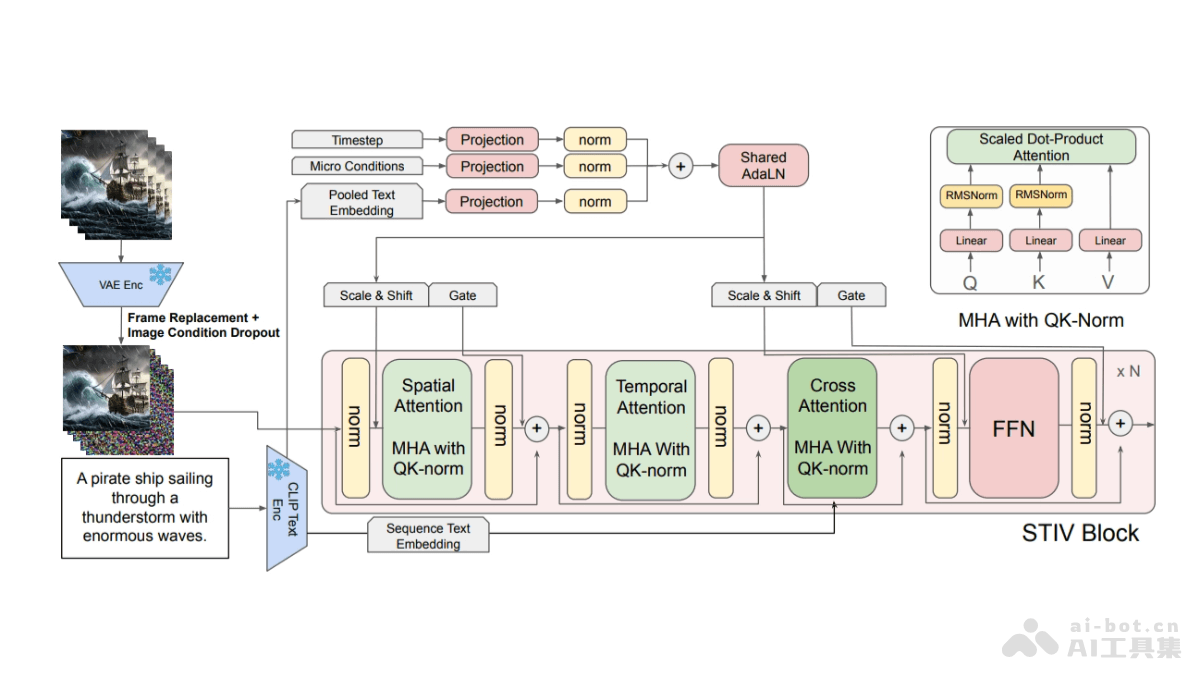

STIV(Scalable Text and Image Conditioned Video Generation)是苹果公司推出的视频生成大模型。STIV拥有8.7亿参数,能处理文本到视频(T2V)和文本图像到视频(TI2V)任务,基于联合图像-文本分类器自由引导(JIT-CFG)提升视频生成质量。STIV模型基于PixArt-Alpha架构,融合时空注意力机制、旋转位置编码(RoPE)和流匹配训练目标,增强视频生成的稳定性和效率。STIV支持多种下游应用,如视频预测、帧插值和长视频生成等。

STIV的主要功能文本到视频(T2V)和文本图像到视频(TI2V)生成:STIV能根据文本提示或结合文本和初始图像帧生成视频内容。多模态条件支持:模型支持基于文本和图像的条件进行视频生成,增强视频内容与输入条件的一致性。视频预测:模型对视频未来帧进行预测,适用于自动驾驶和嵌入式AI等领域。帧插值:在给定的帧之间生成中间帧,提高视频的流畅度和连续性。多视角生成:从单一视角生成视频的新视角,增强视频的立体感和真实感。长视频生成:基于关键帧预测和帧插值技术,生成更长时长的视频内容。STIV的技术原理Diffusion Transformer(DiT):基于DiT架构,能有效处理时空数据。帧替换:在训练过程中,将噪声帧替换为无噪声的图像条件帧,增强视频生成的准确性和一致性。联合图像-文本分类器自由引导(JIT-CFG):一种无分类器引导技术,调整文本和图像条件的权重,优化视频生成过程。时空注意力机制:基于分解的时空注意力机制,分别处理空间和时间维度的特征,提高模型的效率和效果。旋转位置编码(RoPE):RoPE增强模型处理相对时空关系的能力,更好地适应不同分辨率的生成任务。流匹配训练目标:用流匹配目标替代传统的扩散损失,实现更优的条件最优传输策略,提升生成质量。STIV的项目地址HuggingFace模型库:https://huggingface.co/papers/2412.07730arXiv技术论文:https://arxiv.org/pdf/2412.07730STIV的应用场景娱乐与社交媒体:用户生成个性化的视频内容,如舞蹈、旅行或日常生活的短视频,在抖音、Instagram等社交平台上分享。广告与营销:企业创建动态的广告视频,根据产品特点或服务优势快速生成吸引人的视频内容,提高广告的吸引力和转化率。教育与培训:教育机构生成教育视频,如模拟实验过程或历史事件,为学生提供更加直观和互动的学习体验。新闻与报道:新闻机构将新闻报道转化为视频内容,快速生成新闻故事的可视化呈现,提高新闻的传播效率和观众的理解度。自动驾驶与仿真:自动驾驶技术公司生成各种交通场景的视频,测试和训练自动驾驶系统的决策和反应能力。

STIV的主要功能文本到视频(T2V)和文本图像到视频(TI2V)生成:STIV能根据文本提示或结合文本和初始图像帧生成视频内容。多模态条件支持:模型支持基于文本和图像的条件进行视频生成,增强视频内容与输入条件的一致性。视频预测:模型对视频未来帧进行预测,适用于自动驾驶和嵌入式AI等领域。帧插值:在给定的帧之间生成中间帧,提高视频的流畅度和连续性。多视角生成:从单一视角生成视频的新视角,增强视频的立体感和真实感。长视频生成:基于关键帧预测和帧插值技术,生成更长时长的视频内容。STIV的技术原理Diffusion Transformer(DiT):基于DiT架构,能有效处理时空数据。帧替换:在训练过程中,将噪声帧替换为无噪声的图像条件帧,增强视频生成的准确性和一致性。联合图像-文本分类器自由引导(JIT-CFG):一种无分类器引导技术,调整文本和图像条件的权重,优化视频生成过程。时空注意力机制:基于分解的时空注意力机制,分别处理空间和时间维度的特征,提高模型的效率和效果。旋转位置编码(RoPE):RoPE增强模型处理相对时空关系的能力,更好地适应不同分辨率的生成任务。流匹配训练目标:用流匹配目标替代传统的扩散损失,实现更优的条件最优传输策略,提升生成质量。STIV的项目地址HuggingFace模型库:https://huggingface.co/papers/2412.07730arXiv技术论文:https://arxiv.org/pdf/2412.07730STIV的应用场景娱乐与社交媒体:用户生成个性化的视频内容,如舞蹈、旅行或日常生活的短视频,在抖音、Instagram等社交平台上分享。广告与营销:企业创建动态的广告视频,根据产品特点或服务优势快速生成吸引人的视频内容,提高广告的吸引力和转化率。教育与培训:教育机构生成教育视频,如模拟实验过程或历史事件,为学生提供更加直观和互动的学习体验。新闻与报道:新闻机构将新闻报道转化为视频内容,快速生成新闻故事的可视化呈现,提高新闻的传播效率和观众的理解度。自动驾驶与仿真:自动驾驶技术公司生成各种交通场景的视频,测试和训练自动驾驶系统的决策和反应能力。