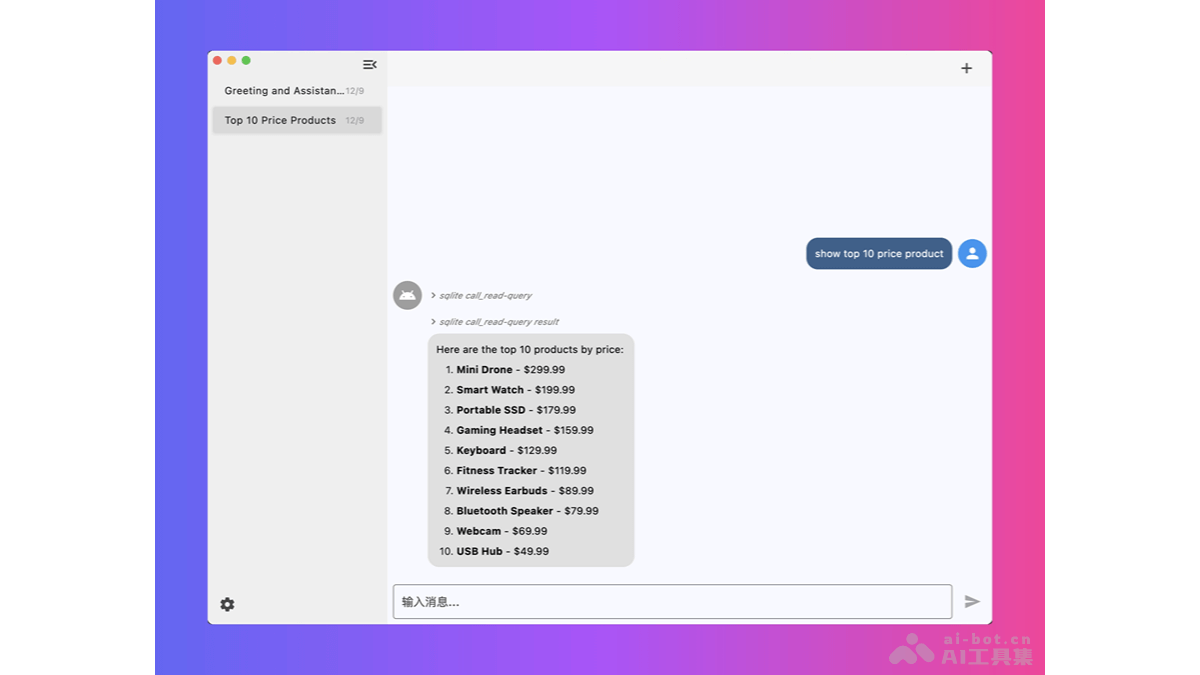

ChatMCP 是基于模型上下文协议(MCP)的 AI 聊天客户端,支持与各种大型语言模型(LLM)如 OpenAI、Claude 和 OLLama 等进行交互。ChatMCP具备自动化安装 MCP 服务器、SSE 传输支持、自动选择服务器、聊天记录管理等功能,提供 MCP 服务器市场实现与不同数据源的聊天。用户能在设置页面配置 LLM API 密钥和端点,享受更好的用户界面设计。

ChatMCP的主要功能与MCP服务器聊天:用户能直接与MCP服务器进行交互,发送和接收消息。MCP服务器市场:提供多种MCP服务器的集合,用户能从中选择并安装,实现与不同数据源的聊天。自动安装MCP服务器:简化MCP服务器的安装过程,用户无需手动配置。SSE MCP传输支持:支持服务器发送事件(Server-Sent Events),服务器能主动向客户端推送信息。自动选择MCP服务器:客户端能自动选择可用的MCP服务器进行连接。聊天记录管理:提供聊天记录的存储和管理功能,方便用户回顾历史对话。支持多种LLM模型:支持与OpenAI、Claude、OLLama等大型语言模型的集成。ChatMCP的技术原理模型上下文协议(MCP):ChatMCP基于MCP协议,支持客户端向服务器发送请求,接收来自服务器的响应。大型语言模型(LLM)集成:ChatMCP基于集成不同的LLM,让客户端能理解和生成自然语言,提供智能对话能力。API密钥和端点配置:用户配置LLM的API密钥和端点,便于客户端与特定的LLM服务进行通信。服务器发送事件(SSE):基于SSE技术,ChatMCP实现服务器向客户端的实时数据推送。数据库和日志管理:ChatMCP用数据库存储聊天记录,基于日志文件记录应用的运行情况,方便调试和维护。ChatMCP的项目地址GitHub仓库:https://github.com/daodao97/chatmcpChatMCP的应用场景客户服务:提供24*7的自动化客户支持,回答常见问题,减少客服工作量。个人助理:帮助用户管理日程、提醒重要事件、搜索信息等。教育和学习:作为教学辅助工具,提供语言学习、答疑解惑等服务。企业内部沟通:用于内部员工之间的沟通,提高工作效率。信息检索:结合大型语言模型,快速检索和提供所需信息。

ChatMCP的主要功能与MCP服务器聊天:用户能直接与MCP服务器进行交互,发送和接收消息。MCP服务器市场:提供多种MCP服务器的集合,用户能从中选择并安装,实现与不同数据源的聊天。自动安装MCP服务器:简化MCP服务器的安装过程,用户无需手动配置。SSE MCP传输支持:支持服务器发送事件(Server-Sent Events),服务器能主动向客户端推送信息。自动选择MCP服务器:客户端能自动选择可用的MCP服务器进行连接。聊天记录管理:提供聊天记录的存储和管理功能,方便用户回顾历史对话。支持多种LLM模型:支持与OpenAI、Claude、OLLama等大型语言模型的集成。ChatMCP的技术原理模型上下文协议(MCP):ChatMCP基于MCP协议,支持客户端向服务器发送请求,接收来自服务器的响应。大型语言模型(LLM)集成:ChatMCP基于集成不同的LLM,让客户端能理解和生成自然语言,提供智能对话能力。API密钥和端点配置:用户配置LLM的API密钥和端点,便于客户端与特定的LLM服务进行通信。服务器发送事件(SSE):基于SSE技术,ChatMCP实现服务器向客户端的实时数据推送。数据库和日志管理:ChatMCP用数据库存储聊天记录,基于日志文件记录应用的运行情况,方便调试和维护。ChatMCP的项目地址GitHub仓库:https://github.com/daodao97/chatmcpChatMCP的应用场景客户服务:提供24*7的自动化客户支持,回答常见问题,减少客服工作量。个人助理:帮助用户管理日程、提醒重要事件、搜索信息等。教育和学习:作为教学辅助工具,提供语言学习、答疑解惑等服务。企业内部沟通:用于内部员工之间的沟通,提高工作效率。信息检索:结合大型语言模型,快速检索和提供所需信息。