k1 视觉思考模型是kimi推出的k1系列强化学习AI模型,原生支持端到端图像理解和思维链技术,将能力扩展到数学之外的更多基础科学领域。k1模型在图像理解、数学、物理、化学等学科的基准测试中表现优异,超过全球多个标杆模型(如OpenAI o1、GPT-4o以及 Claude 3.5 Sonnet)。k1 视觉思考模型能直接处理图像信息进行思考得出答案,无需借助外部OCR或视觉模型,提供完整的推理思维链,让用户看到模型思索答案的全过程。k1 视觉思考模型基于预训练和强化学习后训练,优化字符识别能力,在 OCRBench 上得到 903 分的当前最好(state-of-the-art)结果,在 MathVista-testmini、MMMU-val 和 DocVQA 基准测试集上分数分别为 69.1、66.7 和 96.9,处于全球领先水平。

同时,Kimi 模型研发团队推出针对基础科学学科的标准化图形测试集Science Vista,涵盖不同难度的数理化图片题目,从分布上与实际用户需求较为匹配。测试集将开放给全行业。

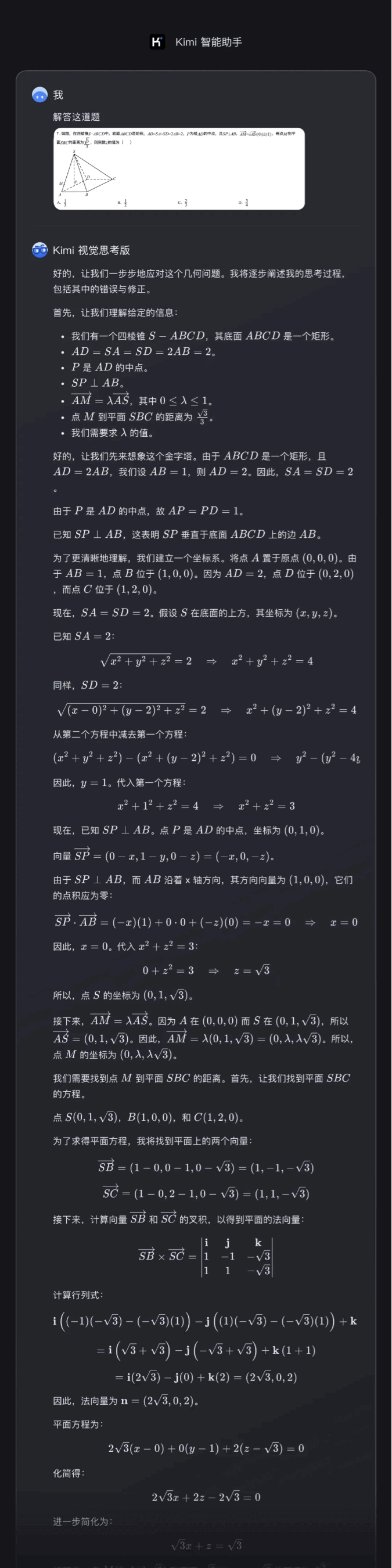

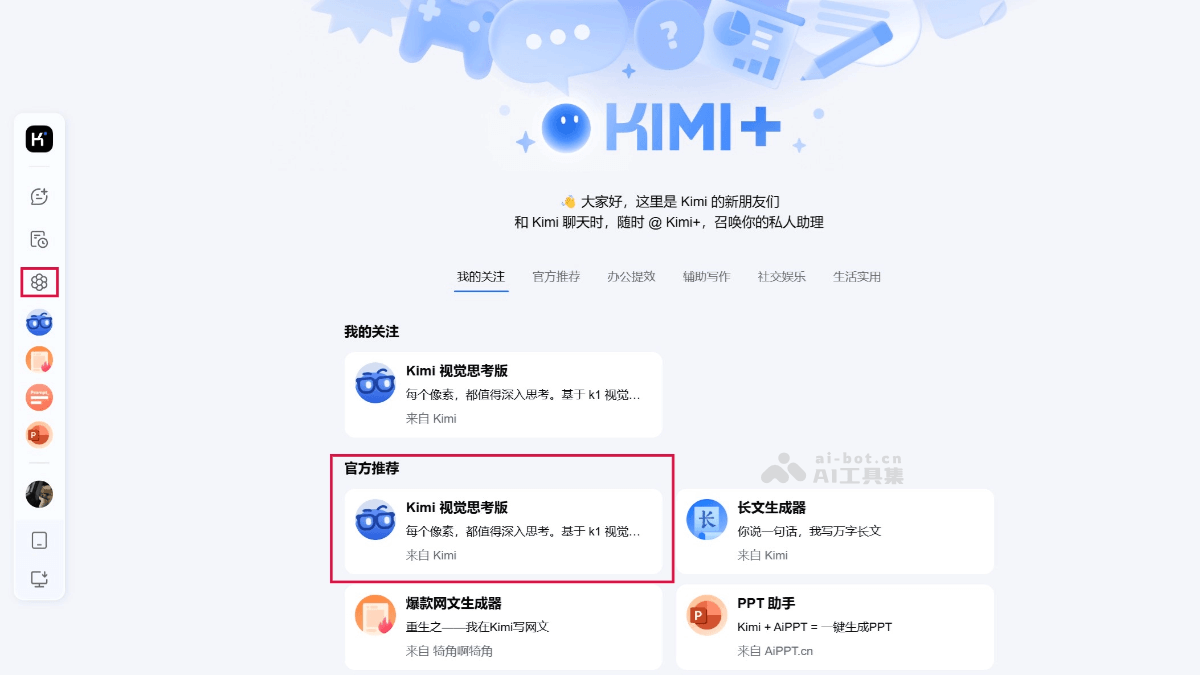

k1 视觉思考模型的主要功能端到端图像理解: k1 视觉思考模型能直接处理用户输入的图像信息,进行深入的思考和分析,无需依赖外部的OCR技术或额外的视觉模型。推理思维链展示:k1 视觉思考模型展示思考过程,即推理思维链(Chain of Thought, CoT),让用户能看到答案,还能看到模型得出答案的逻辑推理过程。基础科学能力泛化数学能力:新的 k1 视觉思考模型,借助端到端的图像理解能力,解锁包括几何图形题在内更加全面的数学能力。跨学科能力:模型的能力扩展到物理、化学等其他基础科学领域,能理解和解决这些领域的复杂问题。真实场景适应性:k1视觉思考模型在包含噪声的真实场景下,如照片灰暗、图像模糊、手写字迹干扰等,k1 模型相比OpenAI 和 Anthropic 的视觉语言模型,有更显著的领先优势。通用问题解决能力:k1视觉思考模型展现出更多通用能力,如解释科学家手稿等,让应用场景更加广泛。如何使用k1 视觉思考模型下载或更新应用:确保手机或电脑上安装最新版的Kimi智能助手APP,或者访问Kimi的网页版。访问Kimi视觉思考版:k1 视觉思考模型已陆续上线最新版「Kimi智能助手」的 Android 和 iPhone 手机APP以及网页( kimi.com)。在最新版手机APP或网页版 Kimi+ 页面找到「Kimi 视觉思考版」。上传或拍照:用APP或网页版中的拍照功能,直接拍摄想要分析的图像,或从设备中上传已有的图片。等待分析:提交图像后,k1 视觉思考模型将开始处理图像信息,进行深入的思考和分析。查看结果和推理过程:Kimi视觉思考版会展示模型的推理思维链(Chain of Thought, CoT),用户能看到模型得出答案的全过程。交互和反馈:如果需要进一步的解释或有其他问题,与Kimi进行交互,提供反馈或提出新的问题。

k1 视觉思考模型的主要功能端到端图像理解: k1 视觉思考模型能直接处理用户输入的图像信息,进行深入的思考和分析,无需依赖外部的OCR技术或额外的视觉模型。推理思维链展示:k1 视觉思考模型展示思考过程,即推理思维链(Chain of Thought, CoT),让用户能看到答案,还能看到模型得出答案的逻辑推理过程。基础科学能力泛化数学能力:新的 k1 视觉思考模型,借助端到端的图像理解能力,解锁包括几何图形题在内更加全面的数学能力。跨学科能力:模型的能力扩展到物理、化学等其他基础科学领域,能理解和解决这些领域的复杂问题。真实场景适应性:k1视觉思考模型在包含噪声的真实场景下,如照片灰暗、图像模糊、手写字迹干扰等,k1 模型相比OpenAI 和 Anthropic 的视觉语言模型,有更显著的领先优势。通用问题解决能力:k1视觉思考模型展现出更多通用能力,如解释科学家手稿等,让应用场景更加广泛。如何使用k1 视觉思考模型下载或更新应用:确保手机或电脑上安装最新版的Kimi智能助手APP,或者访问Kimi的网页版。访问Kimi视觉思考版:k1 视觉思考模型已陆续上线最新版「Kimi智能助手」的 Android 和 iPhone 手机APP以及网页( kimi.com)。在最新版手机APP或网页版 Kimi+ 页面找到「Kimi 视觉思考版」。上传或拍照:用APP或网页版中的拍照功能,直接拍摄想要分析的图像,或从设备中上传已有的图片。等待分析:提交图像后,k1 视觉思考模型将开始处理图像信息,进行深入的思考和分析。查看结果和推理过程:Kimi视觉思考版会展示模型的推理思维链(Chain of Thought, CoT),用户能看到模型得出答案的全过程。交互和反馈:如果需要进一步的解释或有其他问题,与Kimi进行交互,提供反馈或提出新的问题。 k1 视觉思考模型的挑战泛化能力:k1模型在分布外(out-of-distribution)的泛化能力还有提升空间,模型在处理训练数据中未涵盖的新类型问题时表现不佳。复杂问题解决:在解决更为复杂的问题时,k1模型的成功率不如处理简单问题时高。噪声场景准确率:在包含各种噪声的真实场景下,尽管k1模型相比其他模型有优势,准确率有待提升。多轮问答效果:k1模型在多轮问答交互中的效果有待提高,涉及到模型对上下文的理解及连续对话中的逻辑连贯性。k1 视觉思考模型的应用场景教育辅助 数学问题解答:分析数学题目的图像,提供解题步骤和答案,帮助学生学习和理解数学概念。学术研究 科学文献分析:研究人员解读科学文献中的图表和数据,获得新的研究见解和发现。图像识别与分析 城市或建筑识别:用户识别不熟悉的城市地标或建筑风格,增加旅行体验的深度和丰富性。艺术与文化 书法作品分析:分析书法作品的风格和历史背景,为书法爱好者提供深入的学习资源。社交媒体 梗图解读:帮助用户理解社交媒体上的梗图和流行文化现象,跨越文化和语言障碍。k1 视觉思考模型几何题解决实例

k1 视觉思考模型的挑战泛化能力:k1模型在分布外(out-of-distribution)的泛化能力还有提升空间,模型在处理训练数据中未涵盖的新类型问题时表现不佳。复杂问题解决:在解决更为复杂的问题时,k1模型的成功率不如处理简单问题时高。噪声场景准确率:在包含各种噪声的真实场景下,尽管k1模型相比其他模型有优势,准确率有待提升。多轮问答效果:k1模型在多轮问答交互中的效果有待提高,涉及到模型对上下文的理解及连续对话中的逻辑连贯性。k1 视觉思考模型的应用场景教育辅助 数学问题解答:分析数学题目的图像,提供解题步骤和答案,帮助学生学习和理解数学概念。学术研究 科学文献分析:研究人员解读科学文献中的图表和数据,获得新的研究见解和发现。图像识别与分析 城市或建筑识别:用户识别不熟悉的城市地标或建筑风格,增加旅行体验的深度和丰富性。艺术与文化 书法作品分析:分析书法作品的风格和历史背景,为书法爱好者提供深入的学习资源。社交媒体 梗图解读:帮助用户理解社交媒体上的梗图和流行文化现象,跨越文化和语言障碍。k1 视觉思考模型几何题解决实例