Audio To Expression

(中国AI网 2024年12月16日)你可能会注意到Avatar说话时看起来像是机器人?僵硬和怪异的嘴部动作会减损体验。这种不太理想的表现是因为头显只支持嘴部动画,但缺乏支持基于视觉的面部追踪和基于音频的技术。

为了进一步解决这个问题,Meta在Horizon OS v71中纳入了Audio To Expression音频到表情。这个功能可以提供更自然的面部动画,甚至不需要基于视觉的传感器。

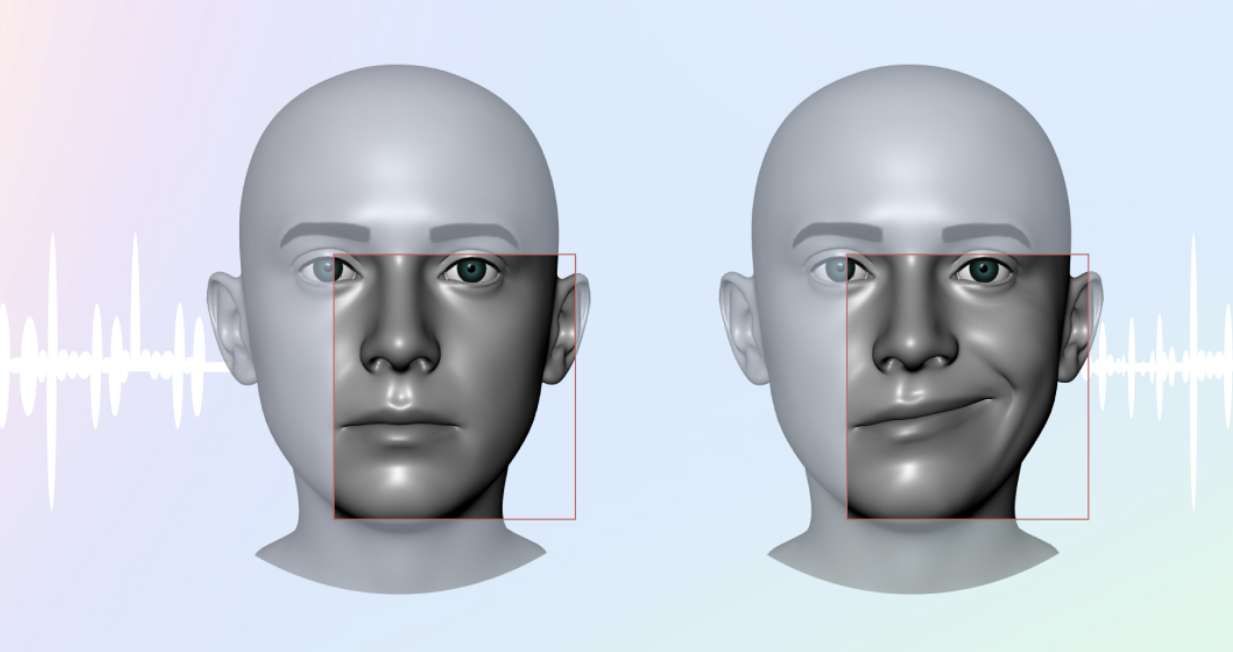

当你交流的时候,大多数表情都来自你脸部的其他部位,比如脸颊、眼睛、眉毛、鼻子。Audio To Expression使用应用中的音频流来生成完整的面部表情,只需声音即可,并能支持细微的肌肉动作。

Audio To Expression的工作原理

Audio To Expression利用了先进的人工智能、Meta的Face Tracking Blendshapes(支持ARKit)和麦克风音频流来提供逼真的完整面部动画。最重要的是,它只需要早期Lipsync库的一小部分开销,从而减少了内存和应用占用。

这个功能已经纳入到Movement SDK,而它主要利用面部追踪来实现用户与Avatar之间的同步面部表示。当设计角色时,你的角色模型必须有Blendshape来激活上脸。团队为XrFaceExpression2FB枚举中定义的每个Blendshape提供了一个可视化示例列表,以便你可以理解各种blendshape如何对应不同的面部表情。

Audio To Expression支持Quest 3s, Quest 3, Quest Pro和Quest 2。

Audio to Expression演示

Audio To Expression可用于各种用例,主要涉及用户之间的社交。Meta在测试和评估过程中与Arthur Technologies进行了合作:

在上面的剪辑中,你可以看到Audio To Expression在企业协作平台Arthur的应用。

Arthur Technologies实现Audio to Expression的目标是通过可视化沟通的细微差别,从而培养用户之间的同理心和信任。你可以看到这个功能所支持的自然面部表情是如何增加用户真实有效交流的能力。

除了生产力或休闲社交环境,Audio to Expression同时可以提高第一人称射击游戏等竞技游戏的吸引力。

与大多数2D数字平台相比,VR和混合现实体验提供了建立更深层次联结的机会。现在有了Audio To Expression,你有了一种更简单、更节约资源的方法来实现可信的、真实的面部表情。更多信息请访问文档(Unity;Unreal;OpenXR)。