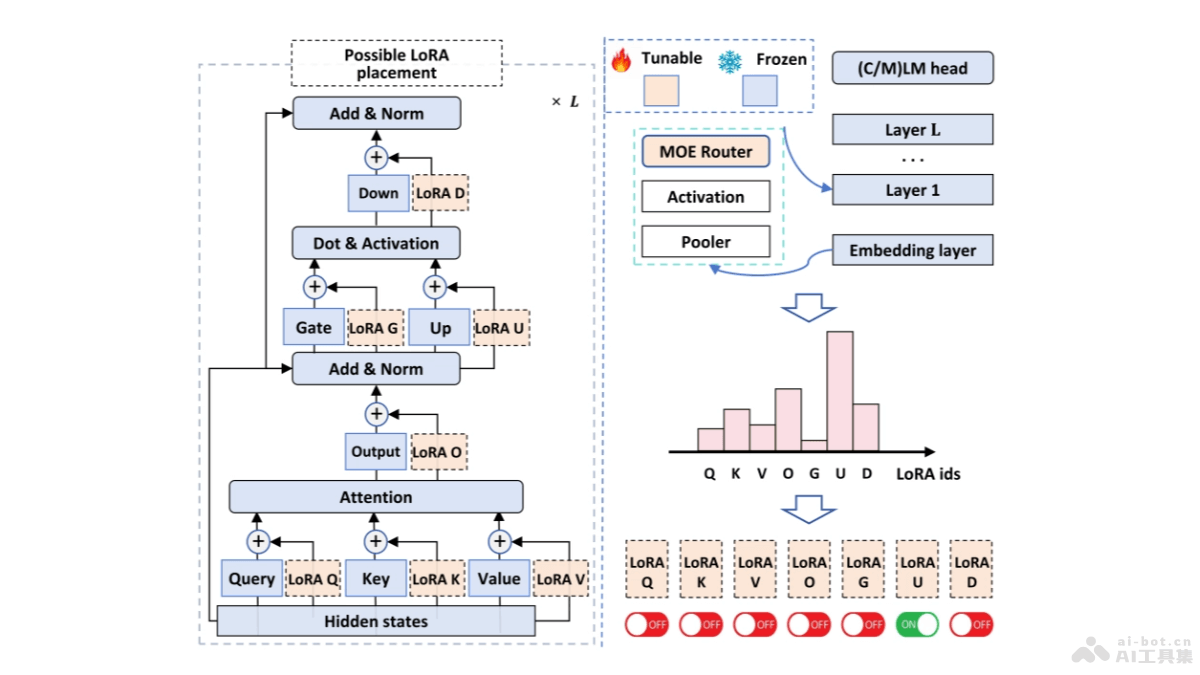

MiLoRA是参数高效的大型语言模型(LLMs)微调方法,通过更新权重分量来矩阵的次要奇异减少计算和内存成本。方法基于奇异值分解(SVD)将权重矩阵分为主要和次要两部分,主要部分包含重要知识,次要部分包含噪声或长尾信息。在微调过程中,MiLoRA保持主要部分不变,只优化次要部分,在适应新任务的同时保留预训练模型的知识。实验表明,MiLoRA在多个基准测试中性能优于传统方法,训练和推理效率更高。

MiLoRA的主要功能参数高效微调:MiLoRA用更少的参数调整来微调大型语言模型,减少计算资源的需求。减少延迟:基于提示的路由机制,MiLoRA减少在多租户环境中生成新标记时的延迟。性能提升:在各种自然语言处理任务中,MiLoRA显示出比传统LoRA方法更好的性能。专家系统:将每个LoRA模块视为一个专家,基于路由机制动态选择最合适的专家进行处理。适应性:根据输入提示动态决定激活哪些LoRA专家,提高模型的适应性和灵活性。MiLoRA的技术原理LoRA模块作为专家:在MiLoRA中,每个LoRA模块被视为一个专家,负责处理特定的任务或数据子集。基于提示的路由机制:MiLoRA引入一个基于输入提示的路由机制,路由机制在生成第一个新标记之前计算专家路由结果,并在后续标记生成中重用结果,避免对每个新标记都进行路由计算的需要。低秩适应(LoRA):基于低秩矩阵对Transformer层的权重进行重新参数化,实现参数的高效调整。动态专家选择:在Transformer层级上,MiLoRA动态选择哪个LoRA专家(即哪个Transformer模块的LoRA)被激活。负载均衡损失:为平衡不同LoRA专家的使用,MiLoRA在训练过程中加入负载均衡损失,确保模型不会过度依赖某些专家。MiLoRA的项目地址arXiv技术论文:https://arxiv.org/pdf/2410.18035MiLoRA的应用场景自然语言处理任务:MiLoRA应用在各种NLP任务中,如文本分类、情感分析、问答系统、机器翻译等,提高模型在特定任务上的性能。多租户环境:在云计算或服务平台中,用在优化资源利用率,减少延迟提升用户体验。在线内容生成:在需要实时生成内容的应用中,如聊天机器人、内容推荐系统等,提高响应速度和处理效率。教育和培训:用在个性化教育平台,基于微调模型适应不同学生的学习习惯和需求。医疗咨询和诊断:在医疗领域,微调模型提供更准确的医疗咨询和诊断建议。

MiLoRA的主要功能参数高效微调:MiLoRA用更少的参数调整来微调大型语言模型,减少计算资源的需求。减少延迟:基于提示的路由机制,MiLoRA减少在多租户环境中生成新标记时的延迟。性能提升:在各种自然语言处理任务中,MiLoRA显示出比传统LoRA方法更好的性能。专家系统:将每个LoRA模块视为一个专家,基于路由机制动态选择最合适的专家进行处理。适应性:根据输入提示动态决定激活哪些LoRA专家,提高模型的适应性和灵活性。MiLoRA的技术原理LoRA模块作为专家:在MiLoRA中,每个LoRA模块被视为一个专家,负责处理特定的任务或数据子集。基于提示的路由机制:MiLoRA引入一个基于输入提示的路由机制,路由机制在生成第一个新标记之前计算专家路由结果,并在后续标记生成中重用结果,避免对每个新标记都进行路由计算的需要。低秩适应(LoRA):基于低秩矩阵对Transformer层的权重进行重新参数化,实现参数的高效调整。动态专家选择:在Transformer层级上,MiLoRA动态选择哪个LoRA专家(即哪个Transformer模块的LoRA)被激活。负载均衡损失:为平衡不同LoRA专家的使用,MiLoRA在训练过程中加入负载均衡损失,确保模型不会过度依赖某些专家。MiLoRA的项目地址arXiv技术论文:https://arxiv.org/pdf/2410.18035MiLoRA的应用场景自然语言处理任务:MiLoRA应用在各种NLP任务中,如文本分类、情感分析、问答系统、机器翻译等,提高模型在特定任务上的性能。多租户环境:在云计算或服务平台中,用在优化资源利用率,减少延迟提升用户体验。在线内容生成:在需要实时生成内容的应用中,如聊天机器人、内容推荐系统等,提高响应速度和处理效率。教育和培训:用在个性化教育平台,基于微调模型适应不同学生的学习习惯和需求。医疗咨询和诊断:在医疗领域,微调模型提供更准确的医疗咨询和诊断建议。