收集了一个数据库EmoHeVRDB(EmojiHeroVR Database)

(中国AI网 2025年03月06日)情感识别通过提供情感反馈和实现高级个性化,促进了虚拟现实体验的评估和增强。但因为头显遮挡了上半脸,面部表情很少用来识别用户的情绪。

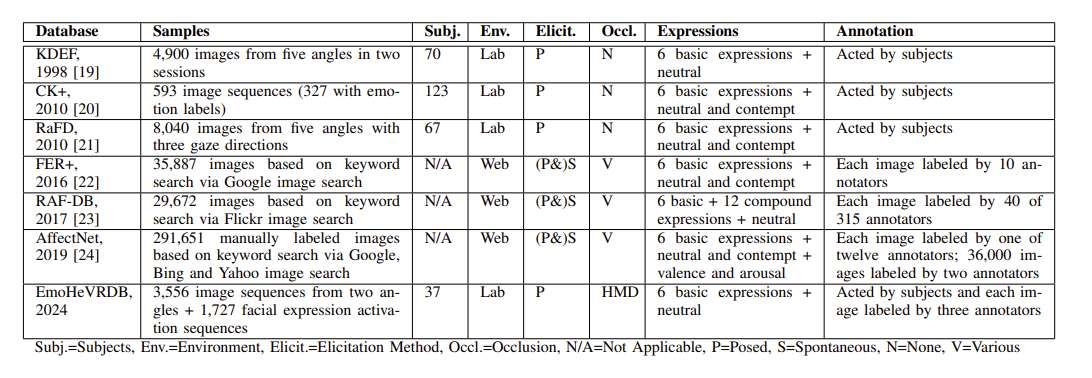

为了解决这个问题,西苏格兰大学和汉堡应用科学大学团队进行了一项研究,并收集了一个数据库EmoHeVRDB(EmojiHeroVR Database),包括3556个标记的面部图像,再现了1778种情绪。

对于每个标记的图像,同时提供了在标记图像之前和之后直接记录的29个额外帧,以促进动态面部表情识别(FER)。另外,EmoHeVRDB包括每帧通过Meta Quest Pro头显捕获的63个面部表情的激活数据。

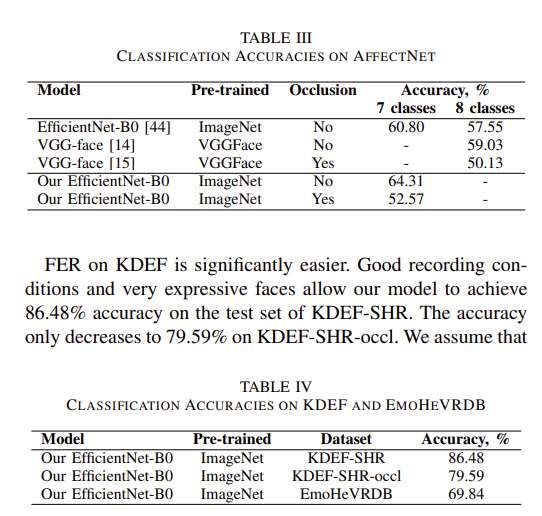

利用这个数据库,团队使用EfficientNet-B0架构对具有六种基本情绪和中性情绪的静态FER分类任务进行了基线评估。最佳模型在测试集的准确率达到了69.84%,表明头显遮挡下的FER是可行的,但比传统的FER更具挑战性。

在过去的十年中,虚拟现实已经成为各种应用和研究领域的成熟技术,包括治疗,培训,教育,娱乐和人类行为。通过头戴式显示器,虚拟现实体验在模拟几乎任意环境的同时,提供了高水平的沉浸感、存在感和交互性。

相关功能使得VR成为可靠的情绪激发和研究的理想工具。反之,情感识别对于评估和增强VR体验同样非常具有价值。

情绪影响人的感知、决策、行为以及整体的心理和生理状态。它们的识别促进了对VR体验的深入分析,使得系统能够直接对用户的情绪状态做出反应,进一步增加交互性和个性化。

面部表情是一种非常自然而有力的表达情感信号。自动面部表情识别(FER)是一个在计算机视觉和情感计算领域有着悠久历史的研究课题。现代方法建立在深度学习模型之上,如卷积神经网络和transformer架构。

通常,基于Ekman的基本情绪理论,FER系统将图像或图像序列分为六到八个情绪类别。尽管更多的研究集中在静态傅里叶变换之上,但动态傅里叶变换系统已经证明,使用多帧包括时间特征可能是有益的。然而,由于头戴式显示器遮挡了上半脸,这严重限制了传统FER系统的能力,所以在当前的VR研究中很少应用FER。

为了解决这个问题,西苏格兰大学和汉堡应用科学大学团队开发了名为《EmojiHeroVR》的游戏,并进行了一项相关研究。他们收集了一个数据库EmoHeVRDB(EmojiHeroVR Database),包括3556个标记的面部图像,再现了1778种情绪。

对于每个标记的图像,同时提供了在标记图像之前和之后直接记录的29个额外帧,以促进动态面部表情识别(FER)。另外,EmoHeVRDB包括每帧通过Meta Quest Pro头显捕获的63个面部表情的激活数据。

利用这个数据库,团队使用EfficientNet-B0架构对具有六种基本情绪和中性情绪的静态FER分类任务进行了基线评估。最佳模型在测试集的准确率达到了69.84%,表明头显遮挡下的FER是可行的,但比传统的FER更具挑战性。

相关论文:EmojiHeroVR: A Study on Facial Expression Recognition under Partial Occlusion from Head-Mounted Displays

当然,团队坦诚研究存在一定局限性,特别是关于收集数据的人口多样性,姿势和自发情绪之间的差异,以及分类情绪模型准确捕捉情绪各个方面的能力。然而,他们强调这是第一个在自然头显遮挡下探索基于图像的FER的用户研究。

他们表示:“我们期待VR中可靠的自动情绪识别带来积极影响,因为存在诸多有益的应用,如治疗和教育可能会从中受益。然而,进一步的发展必须仔细考虑高度沉浸和情感VR环境的能力,以影响人们的情绪。”