解决超高清CGH生成中内存和计算能力不足的问题

(中国AI网 2024年09月20日)基于深度学习的计算机生成全息CGH展示了巨大的潜力,并产生了令人印象深刻的显示质量。然而,大多数现有技术只能生成1080p分辨率的全息图,而这与AR/VR应用所需的超高分辨率(16K+)相去甚远。

当前CGH框架的主要障碍之一在于消费级GPU的可用内存有限,无法生成更高清晰度的全息图。为了克服上述挑战,上海交大团队提出了一种divide-conquer-and-merge策略来解决超高清CGH生成中内存和计算能力不足的问题。

所述算法允许现有的CGH框架能够以更快的速度合成更高清晰度的全息图,同时保持高保真的图像显示质量。团队通过仿真和实验验证了所提框架的功能。通过将策略集成到HoloNet和CCNN中,在训练期间实现了GPU内存使用量的显著降低,分别降低了64.3%和12.9%。

另外,研究人员观察到全息图生成的速度有了实质性的提高,分别加速了3倍和2倍。特别是,他们首次在NVIDIA GeForce RTX 3090 GPU成功地训练和推断了8K清晰度的全息图。

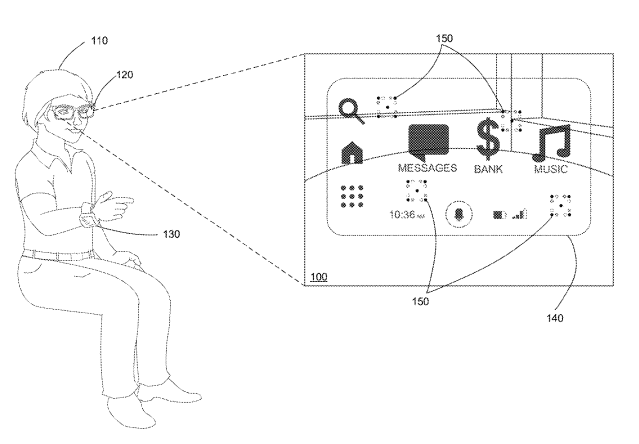

全息显示利用衍射光学元件进行光调制,实现了像素级聚焦控制、像差校正和视觉校准。这是其他显示技术无法实现的事情,所以全息显示有潜力成为下一代虚拟现实和增强现实设备的使能技术。

随着计算算法的进步,计算机生成全息术CGH在通过数值模拟光的传播来合成全息图案方面取得了重大进展。其中,图案模式以顺序的方式加载到空间光调制器SLM,从而实现虚拟对象波前的动态和精确再现。

基于深度学习的CGH方法提供了非常高保真度和逼真的全息图像。尽管在显示质量方面取得了重大进步,但生成超高清全息图依然是一个重大挑战。在实际的VR和AR应用中,需要超高清CGH(16k +)来支持宽视场和大视窗。

然而,由于训练epoch需要大量的GPU内存,大多数全息局限于生成1080p清晰度的全息图。所以,研究在训练阶段减轻GPU内存使用的方法以实现沉浸式VR和AR体验至关重要。

最近,研究人员开始探索新的全息网络架构来生成4K清晰度全息图,例如使用HoloNet中的单个自编码器网络而不是两个子网来生成4K全息图。然而,这种架构表现出明显的显示质量下降。具体而言,与HoloNet相比,其重建图像的PSNR降低了6 dB。

在研究中,上海交大团队提出了一种全新的divide-conquer-and-merge策略,以帮助当前的全息网络生成更高清晰度的全息图。

具体来说,在“divide”阶段,首先在输入图像上应用一个pixel-unshuffle层来获得r2子像素,其中r是pixel-unshuffle层的比例因子。需要注意的是,pixel-unshuffle层可以由具有相同目的的其他操作取代,例如CNN。

接下来,在“conquer”阶段,预测相应的低清晰度全息图。最后在“merge”阶段,将子图像重新排列,以形成更高清晰度的图像。

为了缓解全息图质量的下降,团队设计了一个跨域SR网络以充分集成子全息图中相邻像素之间的信息,从而生成大规模全息图。

另外,团队所提出的框架,如同其他divide算法一样,可以以递归形式实现,从而进一步提高图像质量。

研究人员在两个SOTA网络(Holonet和CCNN)进行了实验以验证其有效性。结果表明,在训练期间,所述方法可以在保持重建图像显示质量的前提下,将GPU内存使用率分别显著降低64.3%和12.9%。

另外,HoloNet的1080p全息图生成速度达到66 FPS,而naïve HoloNet的生成速度仅为16 FPS。与基线CCNN相比,所述方法实现了2×和1.5×速度生成4K和8K全息图。特别是,在模拟中首次成功地在NVIDIA GeForce RTX 3090 GPU训练和推断了8K清晰度全息图。

相关论文:Divide-Conquer-and-Merge: Memory- and Time-Efficient Holographic Displays

总的来说,团队提出了一种divide-conquer-and-merge策略来解决大规模CGH生成中内存和计算能力不足的问题。通过将提出的方法结合到当前的SOTA CGH神经网络中,其能偶在不影响图像质量的情况下显著减少了GPU内存的使用并改善了推理时间。

特别是,研究人员首次在NVIDIA GeForce RTX 3090 GPU成功训练和推断了8K清晰度全息图。未来的目标是进一步优化当前CGH神经网络的内存使用,以生成16K+清晰度的全息图。