团队希望最终设计出一种仅使用标准AR/VR头显附带的传感器就能提供触觉反馈的控制器。

(中国AI网 2024年11月18日)在AR/VR体验中,用户的手臂和手可以为触控输入提供方便的触觉表面。先前的研究表明,与目前常见的悬空操作相比,体表输入具有显著的速度、准确性和人体工程学优势。

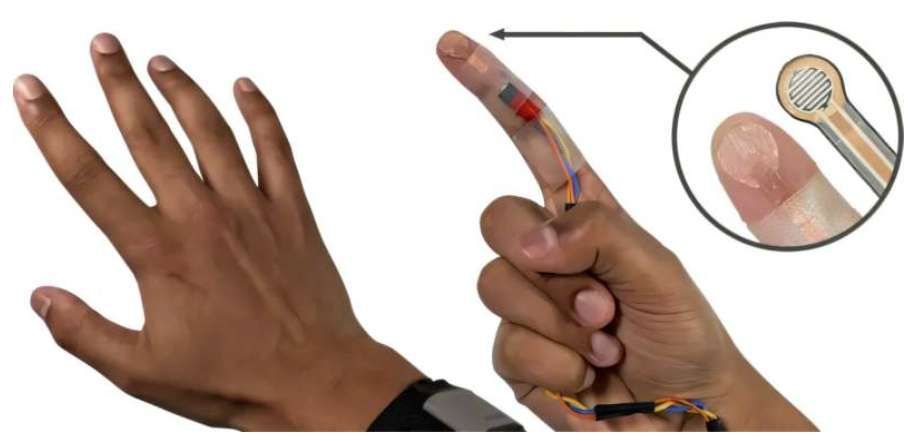

卡内基梅隆大学日前介绍了一种基于人工智能的人机界面EgoTouch,并允许用户将自己的身体变成AR/VR控制器。

在这项研究中,团队展示了高精度的裸手皮肤输入,并且仅仅使用标准XR头显所附带的RGB摄像头。

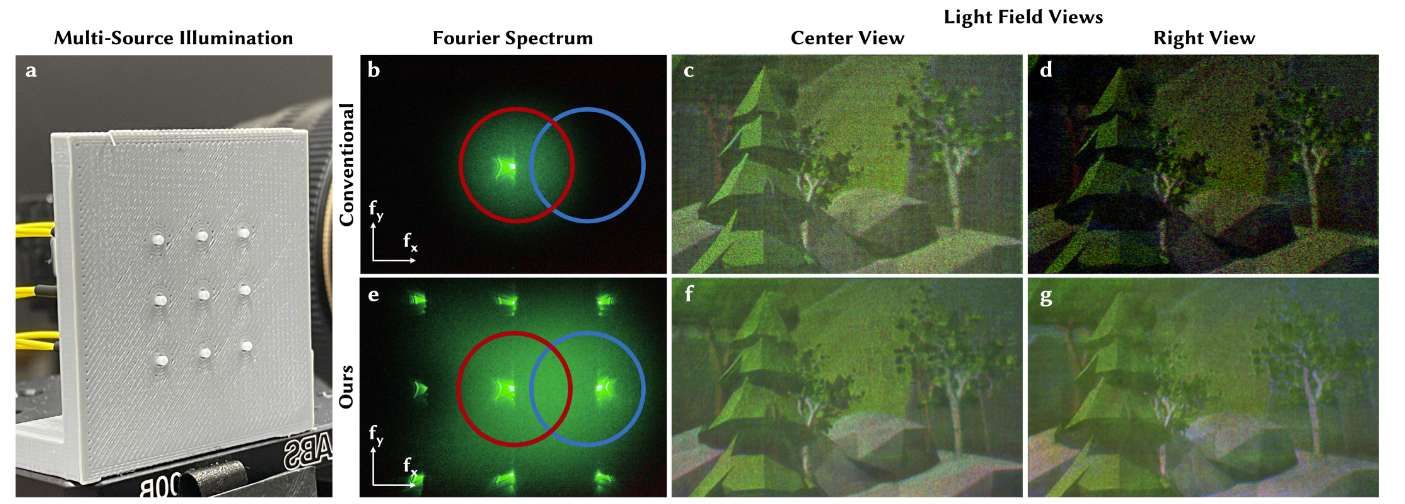

研究人员指出:“试着抬起你的手指,看看当你用它伸向另一个手并触及皮肤时会发生什么。你会注意到只有当你触控皮肤时才会出现这种阴影和局部皮肤变形。如果我们能检测到,我们就可以训练一个机器学习模型来做同样的事情,而这基本上就是我们所做的事情。”

为了给EgoTouch收集数据,团队在食指和手掌安装一个定制的触控传感器。传感器可以在非摄像头视场下收集不同类型的触碰在不同力量下的数据。然后,模型学习将阴影和皮肤变形的视觉特征与触碰和力联系起来,无需人工注释。

团队进一步扩大了训练数据收集范围,包括15名肤色和毛发密度不同的用户,并在一系列不同的情况、活动和光照条件下收集了数小时的数据。

实验结果表明,这种方法在不同的光照条件、肤色和身体运动(例如走路时的输入)下都是准确而稳健的。最后,管道提供了丰富的输入元数据,包括触控力、手指识别和旋转等。

EgoTouch检测触碰的准确率超过96%,假阳性率约为5%。它能识别压下、提起和拖拽。模型同时可以以98%的准确率区分触碰力度。

研究人员表示:“这对于在体表皮肤实现右键点击功能真的很有用。”

检测触碰的变化允许开发者在皮肤模仿触屏手势。例如,智能手机可以识别上下滚动页面、放大、向右滑动或按住图标。为了将其转化为基于皮肤的界面,摄像头需要识别触摸类型和触摸力度之间的细微差异。

在不同的肤色和毛发密度,以及手和前臂的不同区域,如手臂前侧、手臂后侧、手掌和手背,准确率大致相同。不过,系统在指关节等骨骼区域表现不佳。

研究人员解释道:“可能是因为这些部位的皮肤没有那么多变形。作为用户界面设计师,你能做的就是避免在这些区域放置元素。”

值得一提的是,他们正在探索使用夜视摄像头和夜间照明的方法,以支持EgoTouch系统在黑暗中工作。

相关论文:EgoTouch: On-Body Touch Input Using AR/VR Headset Cameras

团队总结道:“这是第一次,我们有一个只需使用已集成到所有头显中的摄像头的系统。我们的模型无需校准,开箱即用。”