复旦大学与百度合作发布了名为"Hallo"的人脸视频生成模型,并在公开的学术论文"Hallo: Hierarchical Audio-Driven Visual Synthesis for Portrait Image Animation"中对该模型进行了详细阐述。这一模型是首个基于扩散技术实现端到端生成高度逼真人脸视频的开源项目。用户只需提供一段音频和所选人像,即可轻松制作出具有极高真实感的人脸视频。这一技术的推出代表着数字人相关的视频生成领域的重要进展。

项目主页:https://fudan-generative-vision.github.io/hallo/

论文链接:https://arxiv.org/abs/2406.08801

GitHub链接:https://github.com/fudan-generative-vision/hall

端到端人脸视频生成方案

1.分层音画特征融合

2.不同人脸特征的控制能力

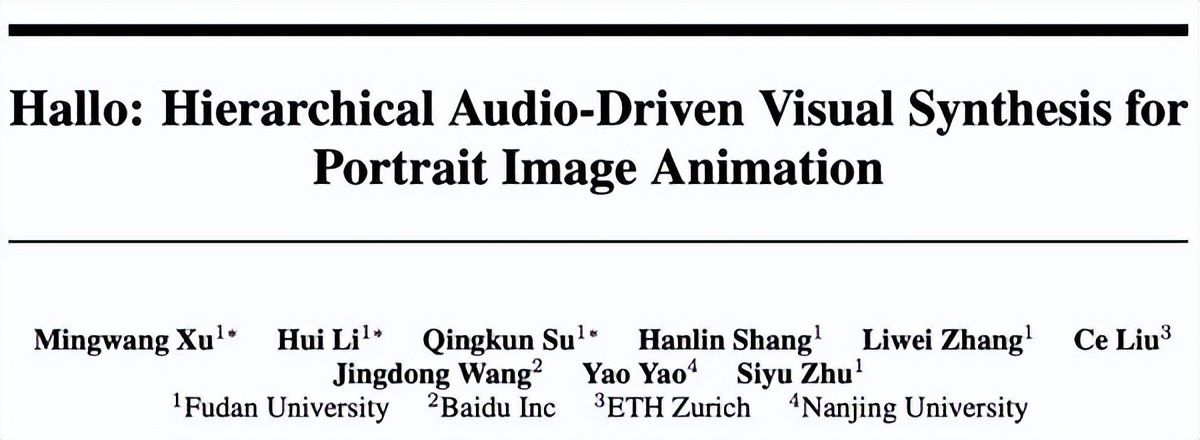

在Hallo系统中的分层音频-视觉注意力机制具有将音频特征与图像的不同区域进行融合对齐的能力,从而提升口型、表情和姿势的精准度和自然度,并提供了全局运动的可控性。通过调整各区域的权重,可以实现对不同区域视频运动的精确控制。此外,Hallo采用专门的人脸编码模型来替代传统的图像-语义预训练模型(如CLIP)。人脸编码模型的主要目的是生成高度保真的肖像身份特征。与以往通过在大型图像和文本描述数据集上进行联合训练CLIP以获得通用视觉特征编码的方法不同,Hallo使用预先训练的人脸编码器来提取身份特征。这些特征与扩散网络的交叉注意力模块进行交互,生成与输入角色特征忠实一致的肖像动画。这一方法不仅确保了人脸特征提取的泛化能力,还准确地保留和展现了个人身份特征,例如面部表情、年龄和性别。

3.大规模数字人视频数据集

在训练中,Hallo系统利用了大量高质量的数字人视频数据。尽管互联网上存在大量的数字人视频数据,但这些数据质量参差不齐,存在诸如音画不匹配、背景杂音、视频抖动等各种问题的数据噪声。为了解决这一问题,研发团队构建了一套自动化数字人视频清洗引擎。截至目前,这一引擎已成功清洗了数千小时的高质量数字人视频,涵盖了上万个信息脱敏的数字人肖像。这项工作使得大规模数据训练数字人视频生成模型成为可能。

Hallo实践效果

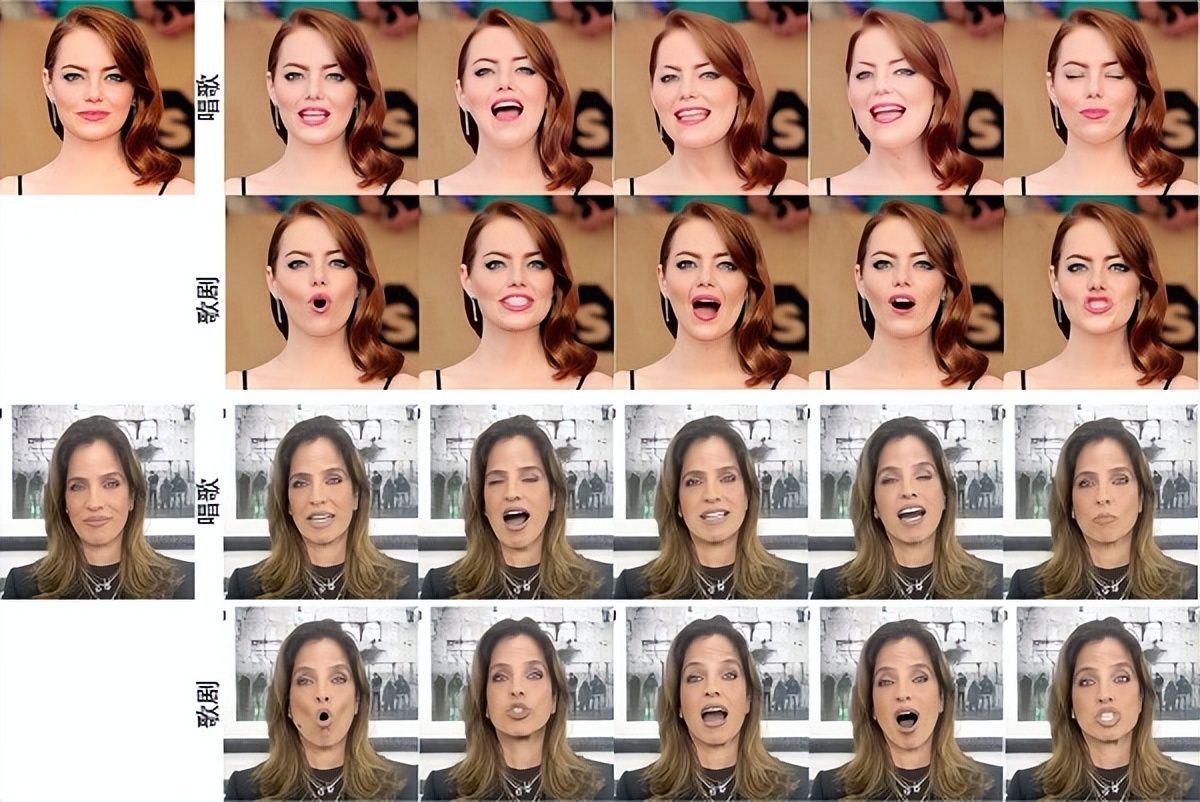

高质量人脸动画生成:在真人数据集上,Hallo展示出了高度一致的口型,并能够体现出音频的丰富细节,如情绪和讲话节奏。

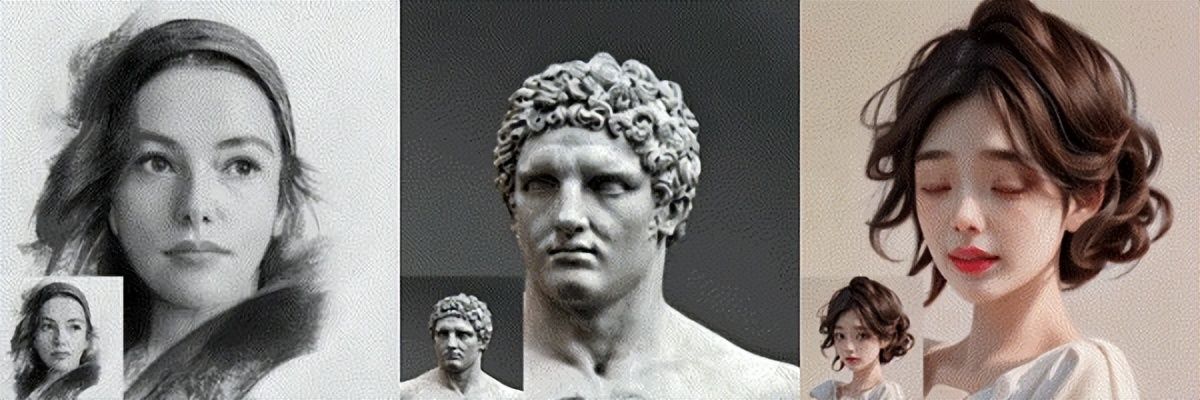

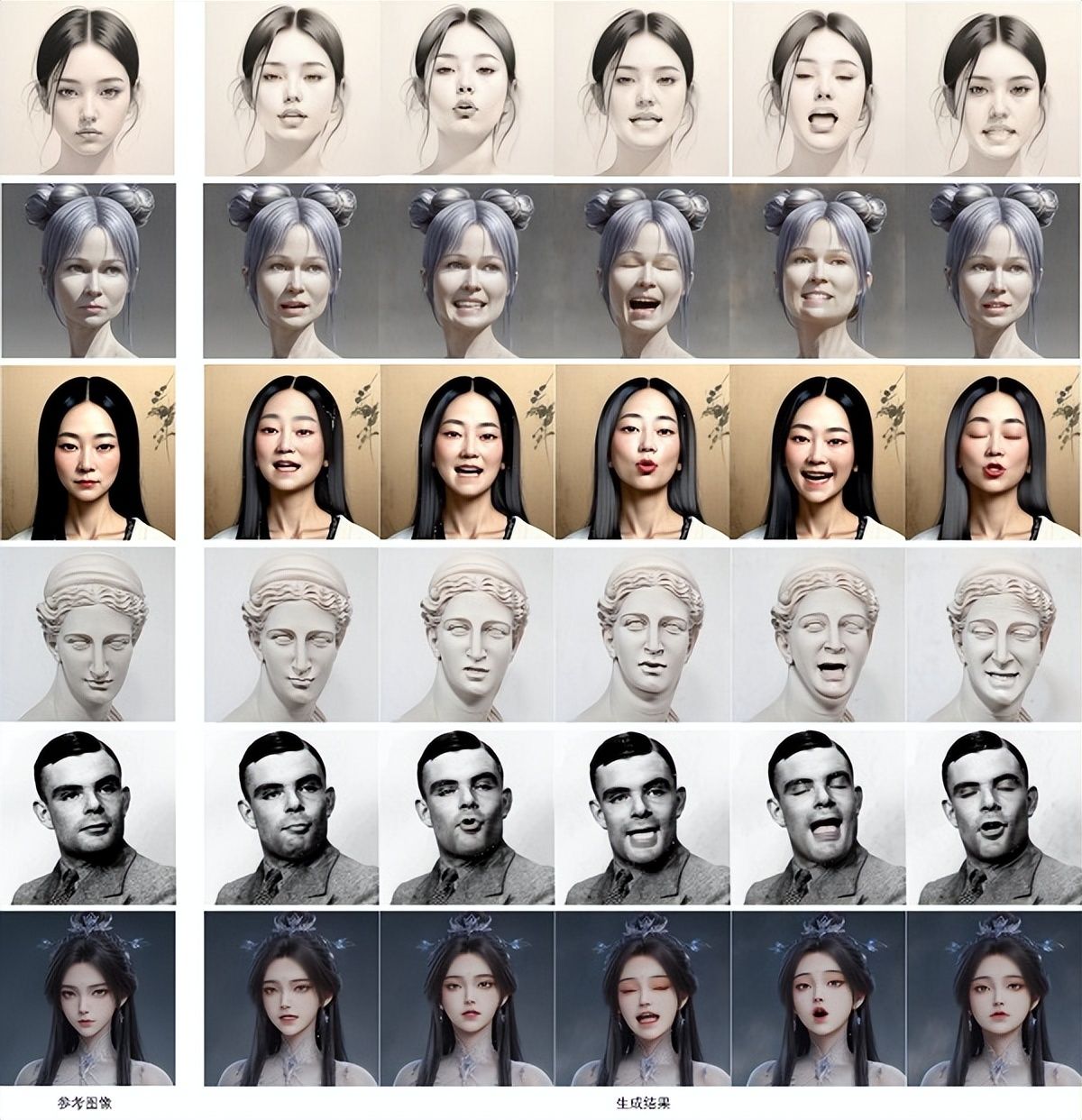

多类型人像风格支持:尽管Hallo仅在真人视频数据集上进行训练,但表现出了极强的泛化性,包括卡通、素描、雕塑等各类风格,这得益于原始扩散模型在超大规模图像数据集上的训练。

全局运动可控性:Hallo的另一个重要特点是全局可控性。相较于以往方法中需要借助参数化模型控制人脸运动强度,Hallo利用分层面部特征注意力机制,通过调整三个区域的权重系数,能针对性地控制口型、表情和动作的运动强度,从而大幅提升人脸动画生成的可控性。

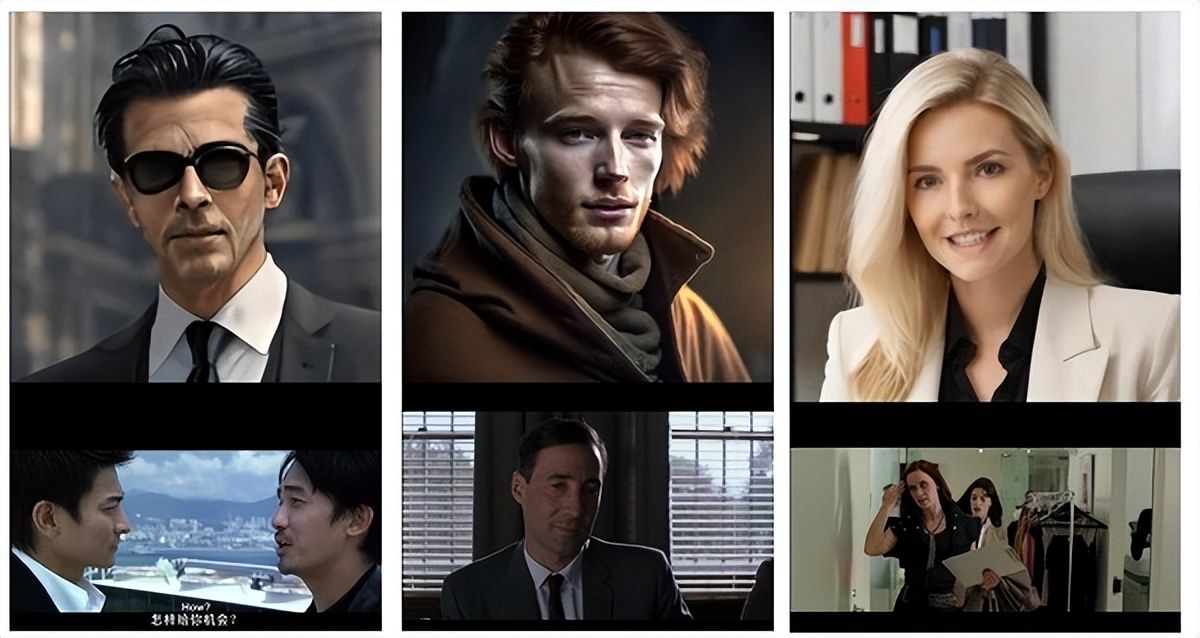

影视制作的潜在应用:除此之外,Hallo展示了在影视制作领域的巨大潜力。通过仅有一段电影对白和一个虚拟角色,可以让虚拟角色生动演绎经典电影场景。

应用前景

Hallo的发布为多个行业带来了广泛的应用前景。在娱乐产业方面,AI驱动的角色动画技术具有广泛的应用潜力,可在电影、电视剧和短视频制作中发挥重要作用。通过运用这项技术,制作团队可以提高制作效率,实现更高质量的动画效果,并最终实现成本的降低。这种技术的运用将为娱乐产业带来更多的创意空间和商业机会。此外,在游戏和虚拟现实领域,AI生成的角色动画为用户提供更加沉浸式的体验。通过引入AI角色,游戏和虚拟现实应用可以呈现更生动、真实的虚拟世界,增强用户的沉浸感和参与感。这将为游戏产业和虚拟现实技术带来新的发展机遇,推动这些领域的创新和进步。

在教育领域,AI数字人对于弱势人群的教学具有极其重要的意义。通过整合AI角色到教学视频和活动中,可以为这一群体设计更具包容性和可访问性的教学方法。AI数字人能通过多感官交互—如视觉、听觉和触觉—增加学习的直观性和互动性。这不仅能够吸引学生的注意力,还能够帮助他们更好地理解抽象概念和复杂信息,从而提高学习的有效性。此外,AI数字人可以模拟悉心的教师角色,提供持续的鼓励和支持,帮助学生在遇到挑战时保持积极和自信。通过这种方式,高质量AI数字人的应用不仅能够提供更符合弱势人群需求的教育内容,还能够帮助他们提高社交技能和生活自理能力,从而更好地融入社会,提高生活质量。这种教育方式的推广和应用,有望为弱势群体打开新的学习大门,为他们带来更多的学习机会和社会参与可能。

未来展望

随着人工智能图形计算(AIGC)技术的飞速进步,AI驱动的角色动画将展现更加逼真自然的表现。未来,复旦和百度的研究团队将持续优化模型性能,提升动画生成质量,并扩展更广泛的应用领域。通过与社区紧密合作和开源共享,Hallo有望在多个产业领域发挥作用,为国家人工智能技术的发展和推广贡献力量。