Delta-CoMe是清华大学NLP实验室联合OpenBMB开源社区、北京大学和上海财经大学提出的新型增量压缩算法,一个80G的A100 GPU能轻松加载多达50个7B模型,节省显存约8倍,同时模型性能几乎与压缩前的微调模型相当。Delta-CoMe基于结合低秩分解和低比特量化技术,用模型参数增量(Delta)的低秩特性,实现混合精度压缩。这种方法能在大幅降低存储和推理成本的同时,保持模型性能几乎无损,尤其在处理数学、代码和多模态等复杂任务时表现出色。

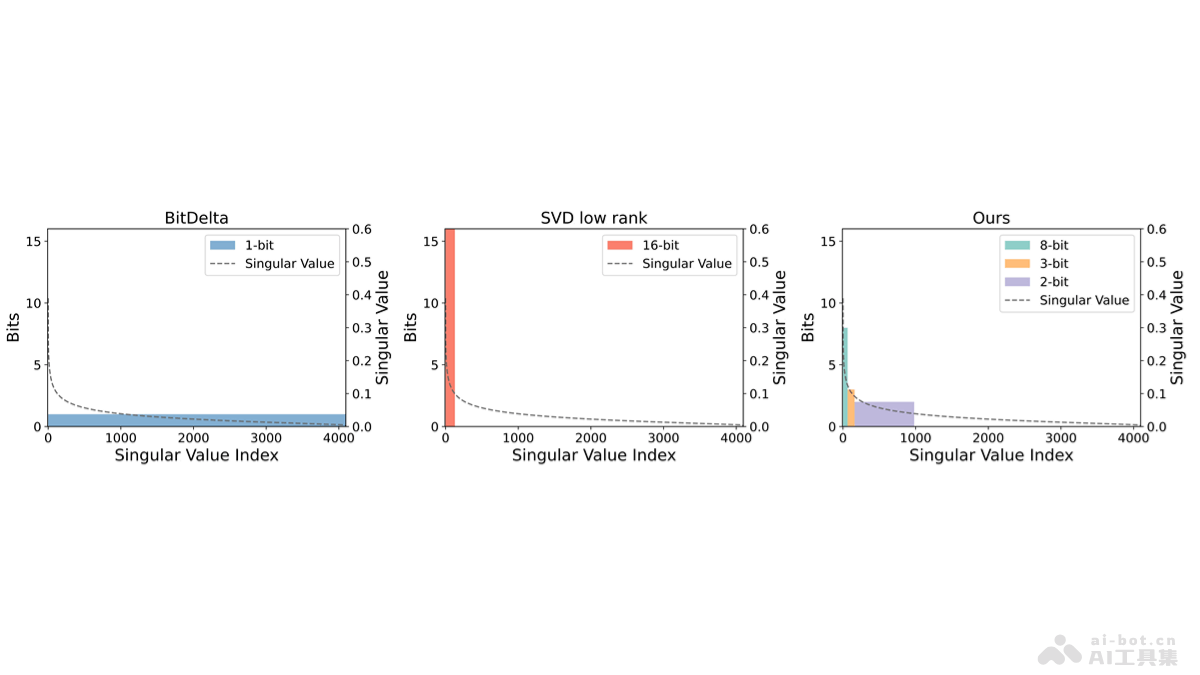

Delta-CoMe的主要功能模型压缩:基于混合精度压缩技术,显著减少大型语言模型(LLMs)的存储和内存需求,让在有限的硬件资源上部署更多的模型成为可能。性能保持:在压缩的同时,保持模型的性能,尤其是在复杂的任务如数学问题解决、代码生成和多模态任务中,确保压缩后的模型性能接近未压缩的微调模型。多任务处理:支持同时部署多个具有不同能力的模型,适用于多租户和多任务处理场景,提高模型部署的灵活性和效率。推理速度提升:基于实现Triton kernel算子,在推理速度上相比PyTorch实现方式提升近3倍,进一步优化模型的运行效率。Delta-CoMe的技术原理低秩分解:用奇异值分解(SVD)对模型参数增量(Delta)进行低秩分解,发现Delta参数具有低秩特性,即大部分变化集中在少数几个主成分上。混合精度量化:基于低秩分解的结果,采用混合精度量化方法,对不同的奇异向量分配不同的位宽。较大奇异值对应的奇异向量用较高精度表示,而较小奇异值对应的奇异向量用较低精度表示,减少存储需求。长尾分布利用:Delta-CoMe观察到Delta参数的奇异值呈现长尾分布,即大部分奇异值较小,只有少数奇异值较大。因此,对于小奇异值对应的奇异向量进行更激进的压缩,对于大奇异值对应的奇异向量保留更高的精度。兼容性和泛化性:Delta-CoMe方法适用于特定的模型或任务,而且具有很好的泛化性,能与不同的主干模型(如Llama-2、Llama-3和Mistral)兼容,并在多种任务上保持良好性能。硬件优化:为进一步提升推理速度,Delta-CoMe实现针对混合精度量化的Triton kernel算子,让在硬件上的部署更加高效。Delta-CoMe的项目地址GitHub仓库:https://github.com/thunlp/Delta-CoMearXiv技术论文:https://arxiv.org/pdf/2406.08903Delta-CoMe的应用场景多租户服务:在云计算环境中,支持在有限的硬件资源上为每个客户提供专用模型,节省显存和计算资源。多任务处理:在需要同时处理多种不同任务的场景中,有效地压缩和部署不同任务的模型。端侧部署:在资源受限的边缘计算设备上,减少模型的存储和内存占用。模型微调服务:对于需要频繁微调以适应新数据或新任务的模型,用压缩微调后的模型增量,减少存储和推理成本。学术研究和开发:研究人员和开发者压缩和部署大型语言模型,进行实验和开发,不受硬件资源的限制。

Delta-CoMe的主要功能模型压缩:基于混合精度压缩技术,显著减少大型语言模型(LLMs)的存储和内存需求,让在有限的硬件资源上部署更多的模型成为可能。性能保持:在压缩的同时,保持模型的性能,尤其是在复杂的任务如数学问题解决、代码生成和多模态任务中,确保压缩后的模型性能接近未压缩的微调模型。多任务处理:支持同时部署多个具有不同能力的模型,适用于多租户和多任务处理场景,提高模型部署的灵活性和效率。推理速度提升:基于实现Triton kernel算子,在推理速度上相比PyTorch实现方式提升近3倍,进一步优化模型的运行效率。Delta-CoMe的技术原理低秩分解:用奇异值分解(SVD)对模型参数增量(Delta)进行低秩分解,发现Delta参数具有低秩特性,即大部分变化集中在少数几个主成分上。混合精度量化:基于低秩分解的结果,采用混合精度量化方法,对不同的奇异向量分配不同的位宽。较大奇异值对应的奇异向量用较高精度表示,而较小奇异值对应的奇异向量用较低精度表示,减少存储需求。长尾分布利用:Delta-CoMe观察到Delta参数的奇异值呈现长尾分布,即大部分奇异值较小,只有少数奇异值较大。因此,对于小奇异值对应的奇异向量进行更激进的压缩,对于大奇异值对应的奇异向量保留更高的精度。兼容性和泛化性:Delta-CoMe方法适用于特定的模型或任务,而且具有很好的泛化性,能与不同的主干模型(如Llama-2、Llama-3和Mistral)兼容,并在多种任务上保持良好性能。硬件优化:为进一步提升推理速度,Delta-CoMe实现针对混合精度量化的Triton kernel算子,让在硬件上的部署更加高效。Delta-CoMe的项目地址GitHub仓库:https://github.com/thunlp/Delta-CoMearXiv技术论文:https://arxiv.org/pdf/2406.08903Delta-CoMe的应用场景多租户服务:在云计算环境中,支持在有限的硬件资源上为每个客户提供专用模型,节省显存和计算资源。多任务处理:在需要同时处理多种不同任务的场景中,有效地压缩和部署不同任务的模型。端侧部署:在资源受限的边缘计算设备上,减少模型的存储和内存占用。模型微调服务:对于需要频繁微调以适应新数据或新任务的模型,用压缩微调后的模型增量,减少存储和推理成本。学术研究和开发:研究人员和开发者压缩和部署大型语言模型,进行实验和开发,不受硬件资源的限制。