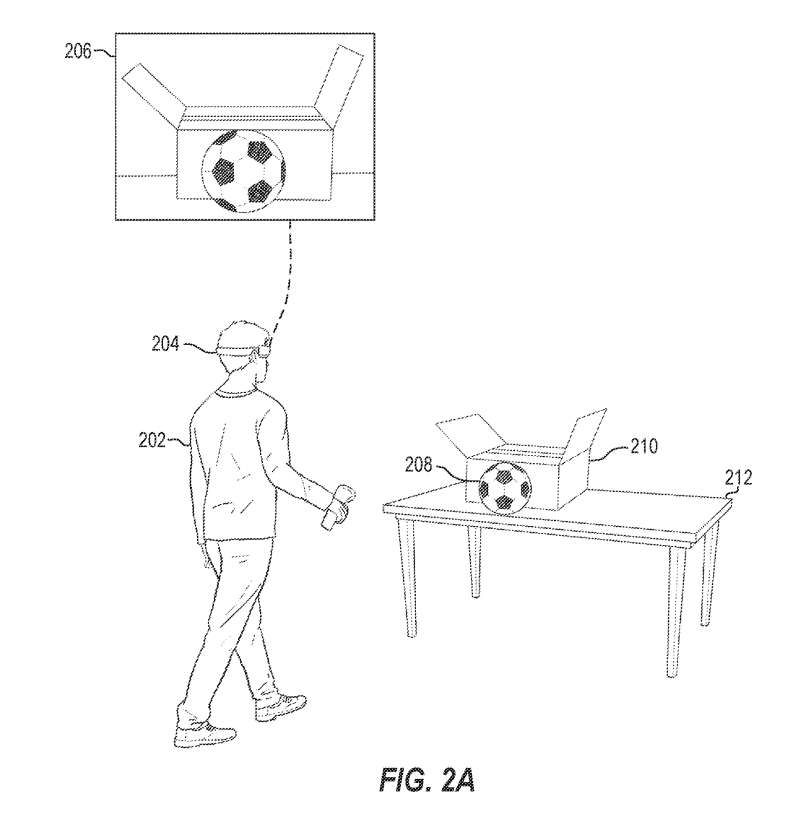

这种速度和视觉质量的结合可以通过提供沉浸式虚拟现实体验或比赛关键时刻的即时重播来支持音乐会和体育比赛的媒体广播

(中国AI网 2024年12月10日)英伟达和马里兰大学联合开发了一个名为QUEEN的人工智能模型,它可以高效实现自由视点视频流媒体,允许用户从任何角度体验3D场景。对于特定高度动态的场景,它将模型大小减少到每帧0.7 MB,而训练时间不到5秒,渲染速度约为350 FPS。

英伟达指出,这种速度和视觉质量的结合可以通过提供沉浸式虚拟现实体验或比赛关键时刻的即时重播来支持音乐会和体育比赛的媒体广播。

英伟达研究主管沙利尼·德梅洛(Shalini De Mello)表示:“为了近乎实时地传输自由视点视频,我们必须同时重建和压缩3D场景。QUEEN平衡了压缩率、视觉质量、编码时间和渲染时间等因素,创造了一个优化的管道,为视觉质量和流媒体性设定了新的标准。”

之前用于生成自由视点视频的人工智能方法要么占用太多内存,要么牺牲视觉质量。QUEEN平衡了这两者,而且能够比先前方法更快地渲染视觉效果,支持流媒体用例。

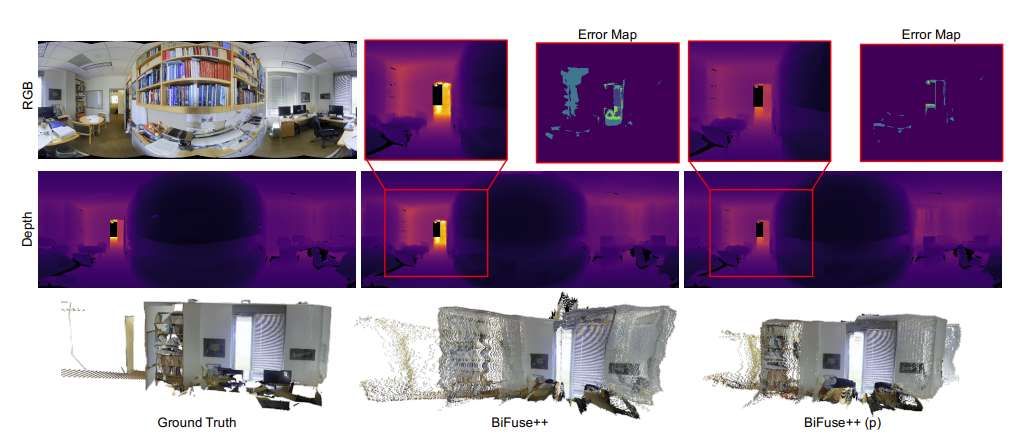

在大多数现实环境中,场景的大多数元素保持静态。在视频中,这意味着大部分像素不会从一帧到另一帧发生变化。为了节省计算时间,QUEEN会专注于重建随时间变化的内容,重用静态区域的渲染。

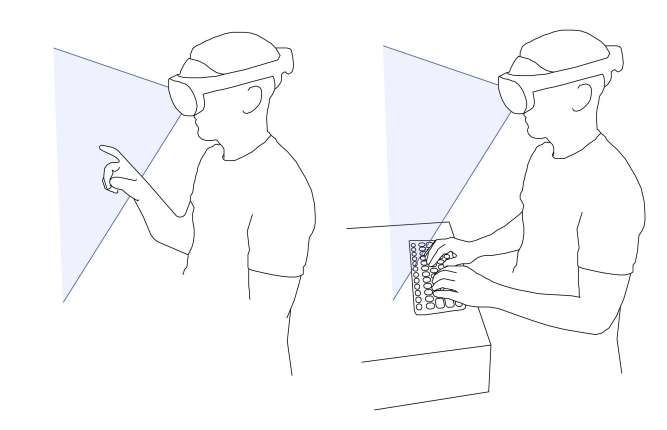

根据团队介绍,QUEEN可以用来构建沉浸式流媒体应用,教授烹饪等技能,允许体育迷从球场中的任何角度欣赏精彩比赛,以及用于工业环境,帮助远程操作仓库等等。

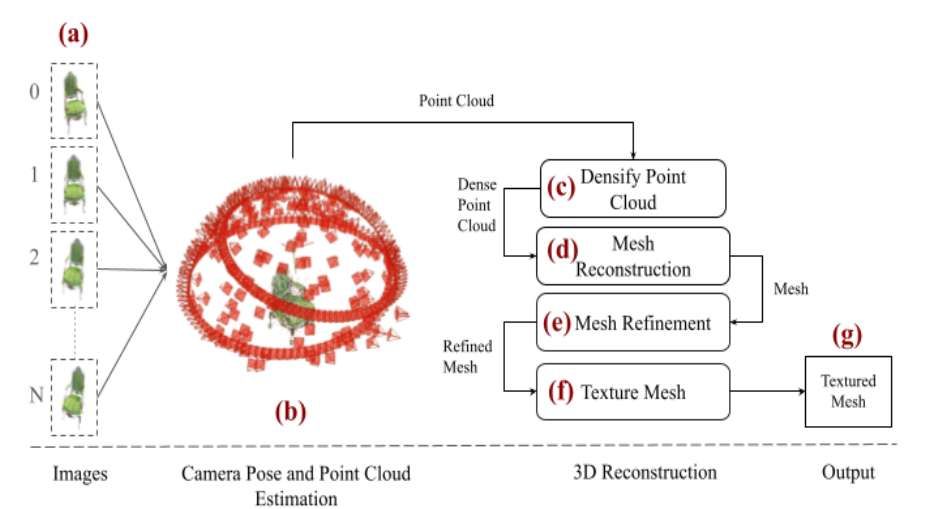

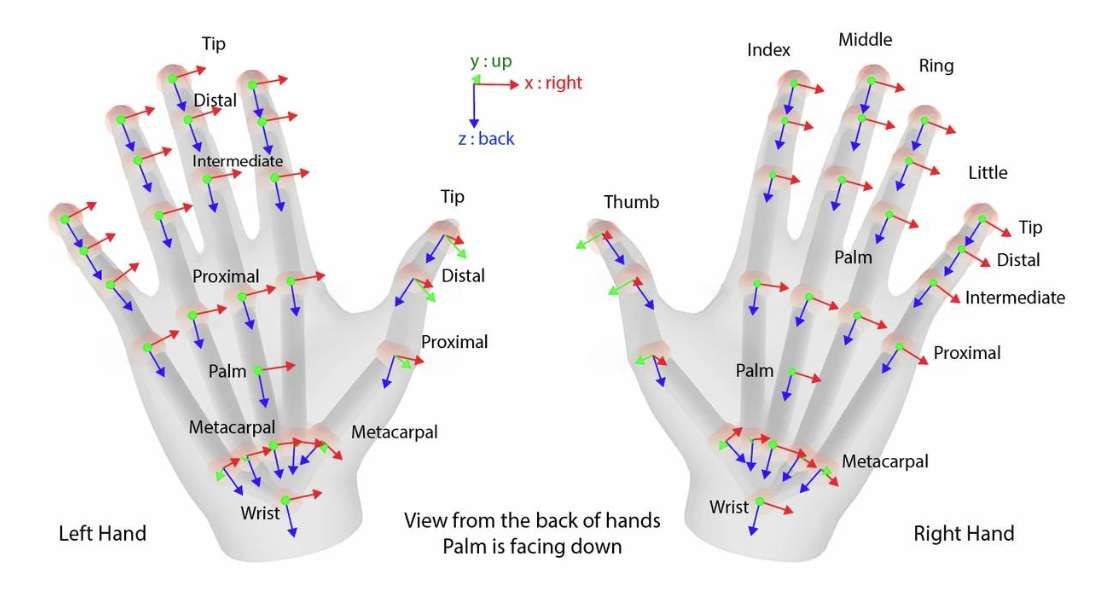

在这项研究中,团队为自由视点流媒体提出了一个3D高斯飞溅的全新框架。QUEEN在每个时间步直接学习连续帧之间的高斯属性残差,不施加任何结构约束,并且具有高质量的重构和可泛化性。

为了有效地存储残差,团队进一步提出了一个量化稀疏框架,它包含一个用于有效量化高斯位置以外的属性残差的经学习latent-decoder,以及一个用于稀疏化位置残差的经学习门控模块。

研究人员提出使用高斯视空间梯度差向量作为信号来分离场景的静态和动态内容。它可作为有效的稀疏性学习和加速训练的指南。在各种FVV基准测试中,QUEEN在所有指标上都优于最先进的在线FVV方法。值得注意的是,对于特定高度动态的场景,它将模型大小减少到每帧0.7 MB,而训练时间不到5秒,渲染速度约为350 FPS。

英伟达表示:“这种速度和视觉质量的结合可以通过提供沉浸式虚拟现实体验或比赛关键时刻的即时重播来支持音乐会和体育比赛的媒体广播。在视频会议应用中,它可以帮助演示者演示烹饪或折纸等任务,同时允许观众选择最有利于他们学习的视角。”

相关项目:QUEEN:QUantized Efficient ENcoding of Dynamic Gaussians for Streaming Free-viewpoint Videos

团队计划开源发布QUEEN的代码,并通过项目页面共享。