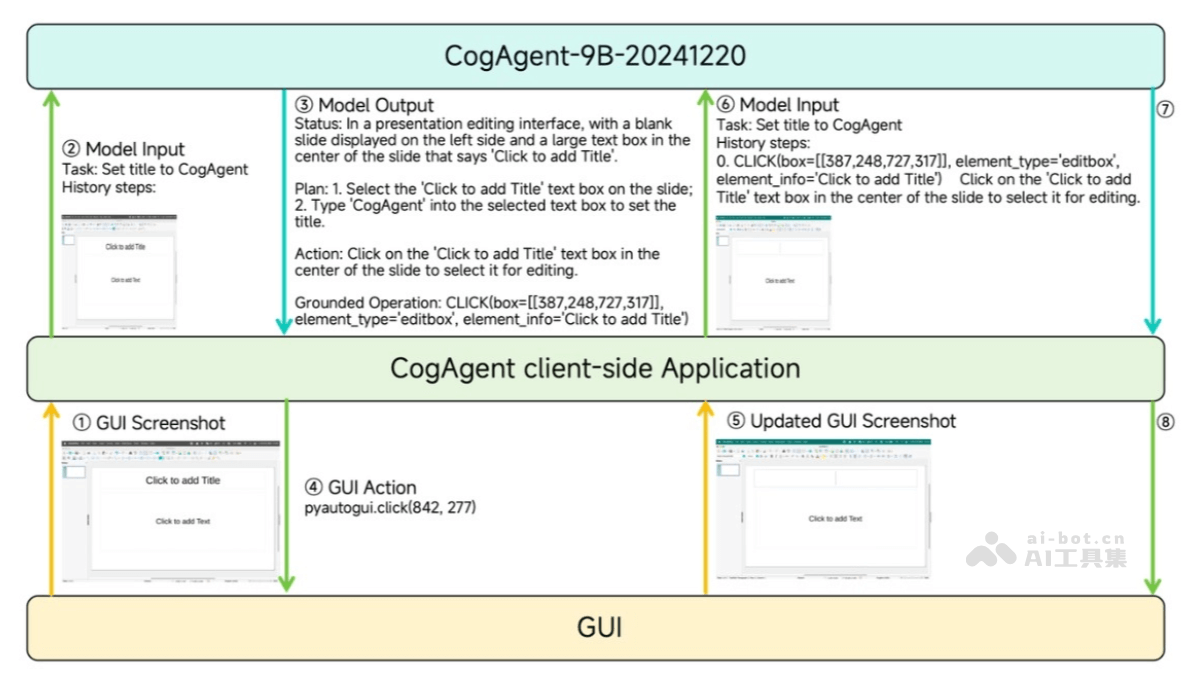

CogAgent-9B是基于 GLM-4V-9B 训练的专用Agent任务模型,仅依赖屏幕截图作为输入,无需HTML等文本表征。CogAgent-9B支持高分辨率图像处理,具备双语(中英文)交互能力,能预测并执行GUI操作,实现自动化任务。在多个GUI操作数据集上取得了领先成绩,模型已开源,推动大模型Agent生态的发展。CogAgent-9B可广泛应用于个人电脑、手机、车机等GUI交互场景。

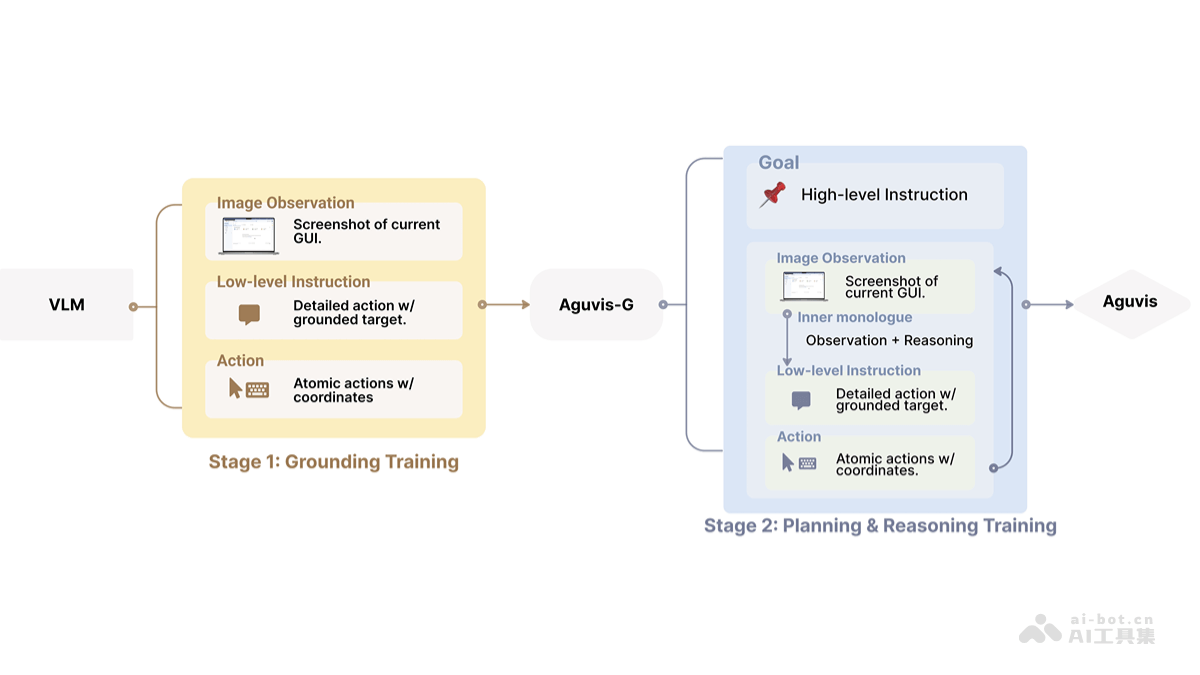

CogAgent-9B的主要功能GUI 理解和操作:CogAgent-9B能理解和操作图形用户界面(GUI),执行如点击按钮、输入文本等任务。屏幕截图输入:模型仅依赖屏幕截图作为输入,无需额外的文本表征,如HTML,使其在多种设备上应用灵活。高分辨率处理:支持高达1120×1120像素的高分辨率图像输入,能够处理更复杂的视觉信息。双语交互:支持中文和英文的屏幕截图和语言交互,增强了模型的国际化应用能力。预测GUI操作:根据用户指定的任务和历史操作,模型能够预测下一步的GUI操作。自动化任务执行:CogAgent-9B能模拟用户操作,自动化执行一系列GUI任务。跨平台应用:适用于个人电脑、手机、车机等多种基于GUI交互的场景。性能领先:在多个GUI操作数据集上取得了领先成绩,显示了其卓越的性能。CogAgent-9B的技术原理视觉语言模型(VLM):CogAgent-9B构建在强大的视觉语言模型GLM-4V-9B之上,能够处理视觉数据(如屏幕截图)和文本信息,实现对GUI元素的理解和操作。双流注意力机制:CogAgent-9B采用双流注意力机制,将视觉元素(例如按钮和图标)映射到它们的文本标签或描述,增强了模型预测用户意图和执行相关操作的能力。GUI Grounding预训练:在预训练阶段,CogAgent-9B引入了GUI Grounding预训练方法,通过屏幕截图和layout对,构造界面子区域和layout表征的对应关系,提升模型对视觉输入和GUI界面的基础理解能力。数据集丰富与完善:CogAgent-9B团队广泛收集并整合了多种数据集,包括无监督数据和GUI指令微调数据集,这些数据集的丰富性和多样性为模型提供了广泛的训练和测试基础。预训练与后训练策略优化:CogAgent-9B在预训练阶段引入了GUI Referring Expression Generation (REG)和GUI Referring Expression Comprehension (REC)任务,以构建界面子区域与布局表征的对应关系。在后训练阶段,采用了更科学的GUI agent后训练策略,使模型具备了更强的分析、推理、预测能力。模型推理及思维链优化:CogAgent-9B将思维链分解为Status(当前屏幕状态)、Plan(全局计划)、Action(下一步自然语言描述)、Operation(下一步形式语言描述),并通过随机采样混合多种模式训练数据,灵活调整和控制推理过程中的实际输出。动作空间完善:CogAgent-9B明确了基础动作空间,新增了LLM、QUOTE_TEXT、LAUNCH等高级动作,增强了模型的使用工具和交互能力。CogAgent-9B的项目地址Github仓库:https://github.com/THUDM/CogAgentHuggingFace模型库:https://huggingface.co/THUDM/cogagent-9b-20241220CogAgent-9B的应用场景自动化测试:在软件开发中,CogAgent-9B可以用于自动化测试,模拟用户操作来测试应用程序的GUI,提高测试效率和覆盖率。智能助手:作为智能个人助理,CogAgent-9B可以帮助用户自动完成日常任务,如日程管理、邮件处理等。客户服务:在客户服务领域,CogAgent-9B可以通过自动化操作来辅助客服人员,快速响应客户需求并执行相关操作。智能家居控制:CogAgent-9B可以集成到智能家居系统中,通过GUI控制家中的各种智能设备。智能座舱:在汽车领域,CogAgent-9B可以用于智能座舱系统,通过GUI与车载信息娱乐系统交互,提供更安全、便捷的驾驶体验。

CogAgent-9B的主要功能GUI 理解和操作:CogAgent-9B能理解和操作图形用户界面(GUI),执行如点击按钮、输入文本等任务。屏幕截图输入:模型仅依赖屏幕截图作为输入,无需额外的文本表征,如HTML,使其在多种设备上应用灵活。高分辨率处理:支持高达1120×1120像素的高分辨率图像输入,能够处理更复杂的视觉信息。双语交互:支持中文和英文的屏幕截图和语言交互,增强了模型的国际化应用能力。预测GUI操作:根据用户指定的任务和历史操作,模型能够预测下一步的GUI操作。自动化任务执行:CogAgent-9B能模拟用户操作,自动化执行一系列GUI任务。跨平台应用:适用于个人电脑、手机、车机等多种基于GUI交互的场景。性能领先:在多个GUI操作数据集上取得了领先成绩,显示了其卓越的性能。CogAgent-9B的技术原理视觉语言模型(VLM):CogAgent-9B构建在强大的视觉语言模型GLM-4V-9B之上,能够处理视觉数据(如屏幕截图)和文本信息,实现对GUI元素的理解和操作。双流注意力机制:CogAgent-9B采用双流注意力机制,将视觉元素(例如按钮和图标)映射到它们的文本标签或描述,增强了模型预测用户意图和执行相关操作的能力。GUI Grounding预训练:在预训练阶段,CogAgent-9B引入了GUI Grounding预训练方法,通过屏幕截图和layout对,构造界面子区域和layout表征的对应关系,提升模型对视觉输入和GUI界面的基础理解能力。数据集丰富与完善:CogAgent-9B团队广泛收集并整合了多种数据集,包括无监督数据和GUI指令微调数据集,这些数据集的丰富性和多样性为模型提供了广泛的训练和测试基础。预训练与后训练策略优化:CogAgent-9B在预训练阶段引入了GUI Referring Expression Generation (REG)和GUI Referring Expression Comprehension (REC)任务,以构建界面子区域与布局表征的对应关系。在后训练阶段,采用了更科学的GUI agent后训练策略,使模型具备了更强的分析、推理、预测能力。模型推理及思维链优化:CogAgent-9B将思维链分解为Status(当前屏幕状态)、Plan(全局计划)、Action(下一步自然语言描述)、Operation(下一步形式语言描述),并通过随机采样混合多种模式训练数据,灵活调整和控制推理过程中的实际输出。动作空间完善:CogAgent-9B明确了基础动作空间,新增了LLM、QUOTE_TEXT、LAUNCH等高级动作,增强了模型的使用工具和交互能力。CogAgent-9B的项目地址Github仓库:https://github.com/THUDM/CogAgentHuggingFace模型库:https://huggingface.co/THUDM/cogagent-9b-20241220CogAgent-9B的应用场景自动化测试:在软件开发中,CogAgent-9B可以用于自动化测试,模拟用户操作来测试应用程序的GUI,提高测试效率和覆盖率。智能助手:作为智能个人助理,CogAgent-9B可以帮助用户自动完成日常任务,如日程管理、邮件处理等。客户服务:在客户服务领域,CogAgent-9B可以通过自动化操作来辅助客服人员,快速响应客户需求并执行相关操作。智能家居控制:CogAgent-9B可以集成到智能家居系统中,通过GUI控制家中的各种智能设备。智能座舱:在汽车领域,CogAgent-9B可以用于智能座舱系统,通过GUI与车载信息娱乐系统交互,提供更安全、便捷的驾驶体验。