DanceFusion是清华大学推出的开源框架,专注于音频驱动的舞蹈动作重建与生成。DanceFusion结合分层时空Transformer-VAE和扩散模型,能处理社交媒体上的不完整和嘈杂骨骼数据,生成与音乐同步的逼真舞蹈动作。DanceFusion技术基于先进的掩码策略和迭代扩散过程,优化动作序列,确保动作生成的高保真度和音乐同步性,广泛应用于内容创作、虚拟现实和互动娱乐等领域。

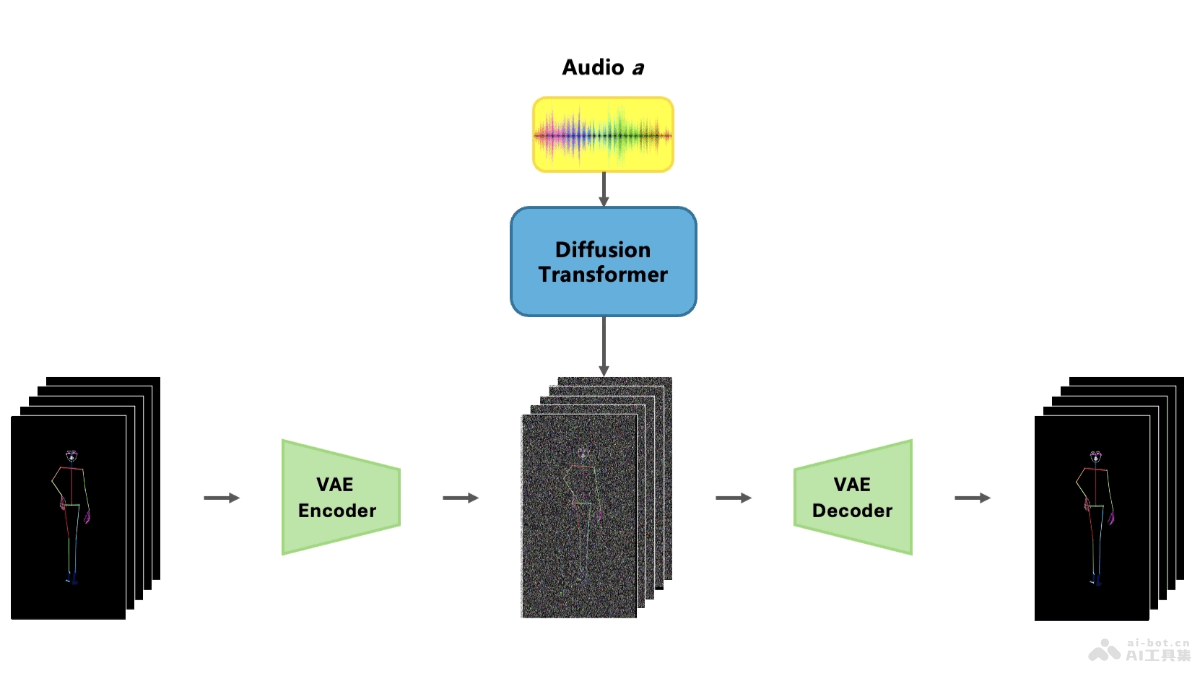

DanceFusion的主要功能音频驱动的舞蹈动作重建与生成:DanceFusion根据音乐生成与音乐同步的舞蹈动作,适用于从社交媒体平台如TikTok提取的不完整和嘈杂的骨骼数据。处理不完整和嘈杂数据:框架能有效处理关节缺失、遮挡和噪声问题,基于分层时空VAE精确捕捉骨骼序列的空间和时间信息。音频与动作的同步:基于扩散模型,DanceFusion能确保舞蹈动作与音乐的节奏、旋律和情感完美契合。先进的掩码技术:开发掩码策略处理不完整的骨骼数据,确保模型在重建过程中只考虑可靠的关节数据。生成高质量舞蹈动作:框架能生成高质量、逼真的舞蹈动作序列,具有高度的多样性和风格。DanceFusion的技术原理分层时空VAE编码:空间编码:将每个骨骼关节视为一个token,捕捉同帧关节间的空间关系。时间编码:学习帧间的时间依赖关系,确保动作序列在时间上的连续性和流畅性。扩散模型:从噪声骨骼序列开始,逐步迭代优化,提升动作逼真度和与音频的同步。掩码机制:在编码阶段应用掩码机制,标记关节的存在或缺失状态,防止模型考虑缺失关节。音频特征融合:在迭代过程中融入音频特征,让生成的动作与音乐实现精准同步。实验评估:用FID和多样性评分评估生成舞蹈序列的质量,确保输出的多样性和非重复性。DanceFusion的项目地址项目官网:th-mlab.github.io/DanceFusionarXiv技术论文:https://arxiv.org/pdf/2411.04646DanceFusion的应用场景内容创作:生成与音乐同步的舞蹈视频,用在社交媒体和视频制作。虚拟现实(VR)和增强现实(AR):为虚拟角色提供自然舞蹈动作,增强沉浸感。互动娱乐和游戏:在游戏中生成逼真的舞蹈动作,提升游戏体验。舞蹈教育和培训:作为教学示范,帮助学习者学习和掌握舞蹈技巧。动画和电影制作:为虚拟角色生成复杂的舞蹈动作,减少动作捕捉需求。

DanceFusion的主要功能音频驱动的舞蹈动作重建与生成:DanceFusion根据音乐生成与音乐同步的舞蹈动作,适用于从社交媒体平台如TikTok提取的不完整和嘈杂的骨骼数据。处理不完整和嘈杂数据:框架能有效处理关节缺失、遮挡和噪声问题,基于分层时空VAE精确捕捉骨骼序列的空间和时间信息。音频与动作的同步:基于扩散模型,DanceFusion能确保舞蹈动作与音乐的节奏、旋律和情感完美契合。先进的掩码技术:开发掩码策略处理不完整的骨骼数据,确保模型在重建过程中只考虑可靠的关节数据。生成高质量舞蹈动作:框架能生成高质量、逼真的舞蹈动作序列,具有高度的多样性和风格。DanceFusion的技术原理分层时空VAE编码:空间编码:将每个骨骼关节视为一个token,捕捉同帧关节间的空间关系。时间编码:学习帧间的时间依赖关系,确保动作序列在时间上的连续性和流畅性。扩散模型:从噪声骨骼序列开始,逐步迭代优化,提升动作逼真度和与音频的同步。掩码机制:在编码阶段应用掩码机制,标记关节的存在或缺失状态,防止模型考虑缺失关节。音频特征融合:在迭代过程中融入音频特征,让生成的动作与音乐实现精准同步。实验评估:用FID和多样性评分评估生成舞蹈序列的质量,确保输出的多样性和非重复性。DanceFusion的项目地址项目官网:th-mlab.github.io/DanceFusionarXiv技术论文:https://arxiv.org/pdf/2411.04646DanceFusion的应用场景内容创作:生成与音乐同步的舞蹈视频,用在社交媒体和视频制作。虚拟现实(VR)和增强现实(AR):为虚拟角色提供自然舞蹈动作,增强沉浸感。互动娱乐和游戏:在游戏中生成逼真的舞蹈动作,提升游戏体验。舞蹈教育和培训:作为教学示范,帮助学习者学习和掌握舞蹈技巧。动画和电影制作:为虚拟角色生成复杂的舞蹈动作,减少动作捕捉需求。