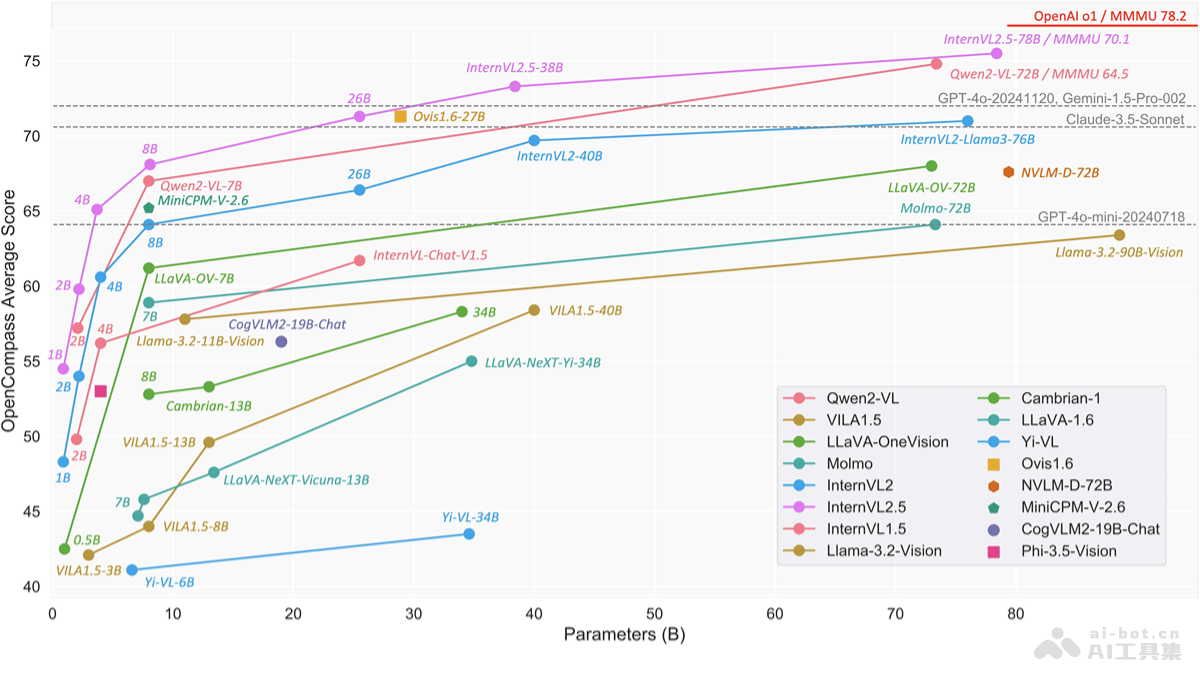

书生·万象InternVL 2.5是上海AI实验室的OpenGVLab团队推出的开源多模态大型语言模型(MLLM)系列。该系列模型在InternVL 2.0的基础上进行显著增强,特别是在训练和测试策略及数据质量方面。InternVL 2.5包括从1B到78B不同规模的模型,适应不同的使用场景和硬件需求。InternVL2_5-78B是首个在多模态理解基准(MMMU)上得分超过70的开源模型,超越ChatGPT-4o和Claude-3.5-Sonnet等商业模型。InternVL 2.5基于链式思考(CoT)推理技术实现性能提升,在多学科推理、文档理解、多图像/视频理解等多个基准测试中展现强大的多模态能力。

书生·万象InternVL 2.5的主要功能多模态理解:处理和理解来自不同模态(文本、图像、视频)的信息。多学科推理:在多个学科领域内进行复杂推理和问题解决。现实世界理解:对现实世界场景和事件进行理解和分析。多模态幻觉检测:识别和区分真实和虚构的视觉信息。视觉地面化:将文本描述与图像中的实际对象相匹配。多语言处理:支持多种语言的理解和生成能力。纯语言处理:执行文本分析、生成和理解等语言任务。书生·万象InternVL 2.5的技术原理ViT-MLP-LLM架构:结合视觉Transformer(ViT)和大型语言模型(LLM)基于MLP投影器。动态高分辨率训练:适应不同分辨率的输入,优化多图像和视频数据的处理。像素逆置操作:减少视觉tokens数量,提高模型效率。渐进式扩展策略:从小规模LLM开始训练,逐步扩展到更大规模的模型。随机JPEG压缩:模拟互联网图像退化,增强模型对噪声图像的鲁棒性。损失重加权:平衡不同长度响应的NTP损失,优化模型训练。书生·万象InternVL 2.5的项目地址GitHub仓库:https://github.com/OpenGVLab/InternVLHuggingFace模型库:https://huggingface.co/OpenGVLab/InternVL2_5arXiv技术论文:https://arxiv.org/pdf/2412.05271在线体验Demo:https://huggingface.co/spaces/OpenGVLab/InternVL书生·万象InternVL 2.5的应用场景图像和视频分析:用在图像和视频内容的自动标注、分类和理解,适用于安防监控、内容审核、媒体娱乐等领域。视觉问答(VQA):在教育、电子商务和客户服务等领域,回答与图像或视频内容相关的问题,提供更丰富的用户体验。文档理解和信息检索:对于法律、医疗和学术研究等领域的大量文档,提取关键信息,支持复杂的查询和研究工作。多语言翻译和理解:InternVL 2.5支持多语言处理,在跨语言交流、国际商务和全球化内容创作中发挥作用。辅助设计和创意工作:在设计和创意产业中,I帮助理解和实现复杂的视觉创意,如建筑设计、广告创意等。

书生·万象InternVL 2.5的主要功能多模态理解:处理和理解来自不同模态(文本、图像、视频)的信息。多学科推理:在多个学科领域内进行复杂推理和问题解决。现实世界理解:对现实世界场景和事件进行理解和分析。多模态幻觉检测:识别和区分真实和虚构的视觉信息。视觉地面化:将文本描述与图像中的实际对象相匹配。多语言处理:支持多种语言的理解和生成能力。纯语言处理:执行文本分析、生成和理解等语言任务。书生·万象InternVL 2.5的技术原理ViT-MLP-LLM架构:结合视觉Transformer(ViT)和大型语言模型(LLM)基于MLP投影器。动态高分辨率训练:适应不同分辨率的输入,优化多图像和视频数据的处理。像素逆置操作:减少视觉tokens数量,提高模型效率。渐进式扩展策略:从小规模LLM开始训练,逐步扩展到更大规模的模型。随机JPEG压缩:模拟互联网图像退化,增强模型对噪声图像的鲁棒性。损失重加权:平衡不同长度响应的NTP损失,优化模型训练。书生·万象InternVL 2.5的项目地址GitHub仓库:https://github.com/OpenGVLab/InternVLHuggingFace模型库:https://huggingface.co/OpenGVLab/InternVL2_5arXiv技术论文:https://arxiv.org/pdf/2412.05271在线体验Demo:https://huggingface.co/spaces/OpenGVLab/InternVL书生·万象InternVL 2.5的应用场景图像和视频分析:用在图像和视频内容的自动标注、分类和理解,适用于安防监控、内容审核、媒体娱乐等领域。视觉问答(VQA):在教育、电子商务和客户服务等领域,回答与图像或视频内容相关的问题,提供更丰富的用户体验。文档理解和信息检索:对于法律、医疗和学术研究等领域的大量文档,提取关键信息,支持复杂的查询和研究工作。多语言翻译和理解:InternVL 2.5支持多语言处理,在跨语言交流、国际商务和全球化内容创作中发挥作用。辅助设计和创意工作:在设计和创意产业中,I帮助理解和实现复杂的视觉创意,如建筑设计、广告创意等。