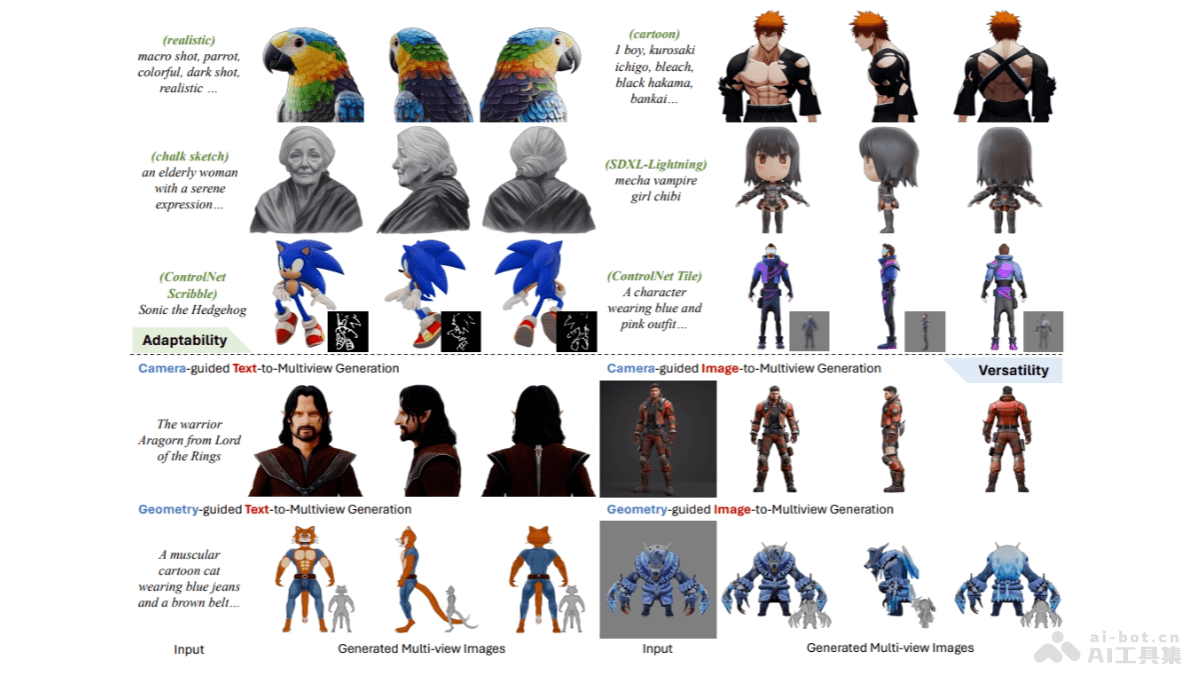

MV-Adapter是多视图一致图像生成模型,是北京航空航天大学、VAST和上海交通大学的研究团队推出的。MV-Adapter能将预训练的文本到图像扩散模型转化为多视图图像生成器,无需改变原始网络结构或特征空间。MV-Adapter基于创新的注意力架构和统一条件编码器,高效地建模多视图一致性和参考图像的相关性,支持生成高分辨率的多视角图像,能适配多种定制模型和插件,实现广泛的应用场景。

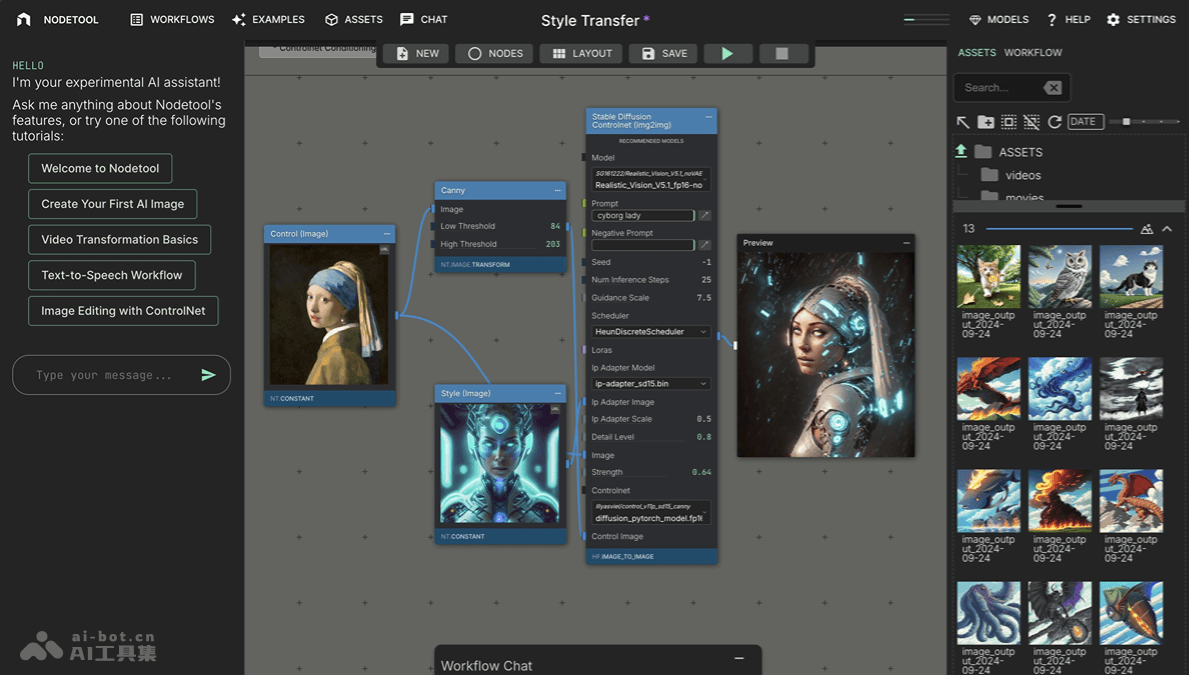

MV-Adapter的主要功能多视图图像生成:MV-Adapter能生成768分辨率的多视角一致图像,是目前最高分辨率的多视图图像生成器之一。适配定制模型:完美适配定制的文本到图像模型、潜在一致性模型(LCM)、ControlNet插件等,实现多视图可控生成。3D模型重建:支持从文本和图像生成多视图图像,并重建3D模型。高质量3D贴图:用已知几何引导生成高质量的3D贴图。任意视角生成:能扩展至从任意视点生成图像,支持更广泛的下游任务。MV-Adapter的技术原理通用条件引导器:设计通用的条件引导器,能编码相机和几何信息,为文本到图像模型提供不同类型的引导,包括相机条件化和几何条件化。解耦的注意力层:推出一种解耦的注意力机制,复制现有的空间自注意力层引入新的多视角注意力层和图像交叉注意力层,避免对基础模型的侵入性修改。并行注意力架构:MV-Adapter的设计将多视角注意力层与图像交叉注意力层并行添加,确保新引入的注意力层与预训练的自注意力层共享输入特征,充分继承原始模型的图像先验信息。多视角注意力机制的具体实现:根据不同的应用需求,设计多种多视角注意力策略,如行级自注意力、行级和列级自注意力相结合,及全自注意力,适应不同的多视角生成需求。图像交叉注意力机制的具体实现:为在生成过程中更精确地引导参考图像信息,推出一种创新的图像交叉注意力机制,在不改变原始文本到图像模型特征空间的情况下,充分利用参考图像的细节信息。MV-Adapter的项目地址项目官网:huanngzh.github.io/MV-AdapterGitHub仓库:https://github.com/huanngzh/MV-AdapterHuggingFace模型库:https://huggingface.co/huanngzh/mv-adapterarXiv技术论文:https://arxiv.org/pdf/2412.03632在线体验Demo单图生成多视图:https://huggingface.co/spaces/VAST-AI/MV-Adapter文字生成二次元风格的多视图:https://huggingface.co/spaces/huanngzh/MV-AdapterMV-Adapter的应用场景2D/3D内容创作:帮助艺术家和设计师在2D和3D领域中创作出更加丰富和真实的视觉内容。虚拟现实(VR)和增强现实(AR):在VR和AR应用中,生成与用户视角变化一致的3D环境和对象,提升沉浸感和交互体验。具身感知与仿真:在机器人和自动化领域,训练和测试机器视觉系统,提高在复杂环境中的导航和操作能力。自动驾驶:生成多视角的交通场景图像,辅助自动驾驶系统进行环境感知和决策制定。3D场景重建:文化遗产保护、建筑建模等领域,快速生成高精度的3D模型。

MV-Adapter的主要功能多视图图像生成:MV-Adapter能生成768分辨率的多视角一致图像,是目前最高分辨率的多视图图像生成器之一。适配定制模型:完美适配定制的文本到图像模型、潜在一致性模型(LCM)、ControlNet插件等,实现多视图可控生成。3D模型重建:支持从文本和图像生成多视图图像,并重建3D模型。高质量3D贴图:用已知几何引导生成高质量的3D贴图。任意视角生成:能扩展至从任意视点生成图像,支持更广泛的下游任务。MV-Adapter的技术原理通用条件引导器:设计通用的条件引导器,能编码相机和几何信息,为文本到图像模型提供不同类型的引导,包括相机条件化和几何条件化。解耦的注意力层:推出一种解耦的注意力机制,复制现有的空间自注意力层引入新的多视角注意力层和图像交叉注意力层,避免对基础模型的侵入性修改。并行注意力架构:MV-Adapter的设计将多视角注意力层与图像交叉注意力层并行添加,确保新引入的注意力层与预训练的自注意力层共享输入特征,充分继承原始模型的图像先验信息。多视角注意力机制的具体实现:根据不同的应用需求,设计多种多视角注意力策略,如行级自注意力、行级和列级自注意力相结合,及全自注意力,适应不同的多视角生成需求。图像交叉注意力机制的具体实现:为在生成过程中更精确地引导参考图像信息,推出一种创新的图像交叉注意力机制,在不改变原始文本到图像模型特征空间的情况下,充分利用参考图像的细节信息。MV-Adapter的项目地址项目官网:huanngzh.github.io/MV-AdapterGitHub仓库:https://github.com/huanngzh/MV-AdapterHuggingFace模型库:https://huggingface.co/huanngzh/mv-adapterarXiv技术论文:https://arxiv.org/pdf/2412.03632在线体验Demo单图生成多视图:https://huggingface.co/spaces/VAST-AI/MV-Adapter文字生成二次元风格的多视图:https://huggingface.co/spaces/huanngzh/MV-AdapterMV-Adapter的应用场景2D/3D内容创作:帮助艺术家和设计师在2D和3D领域中创作出更加丰富和真实的视觉内容。虚拟现实(VR)和增强现实(AR):在VR和AR应用中,生成与用户视角变化一致的3D环境和对象,提升沉浸感和交互体验。具身感知与仿真:在机器人和自动化领域,训练和测试机器视觉系统,提高在复杂环境中的导航和操作能力。自动驾驶:生成多视角的交通场景图像,辅助自动驾驶系统进行环境感知和决策制定。3D场景重建:文化遗产保护、建筑建模等领域,快速生成高精度的3D模型。