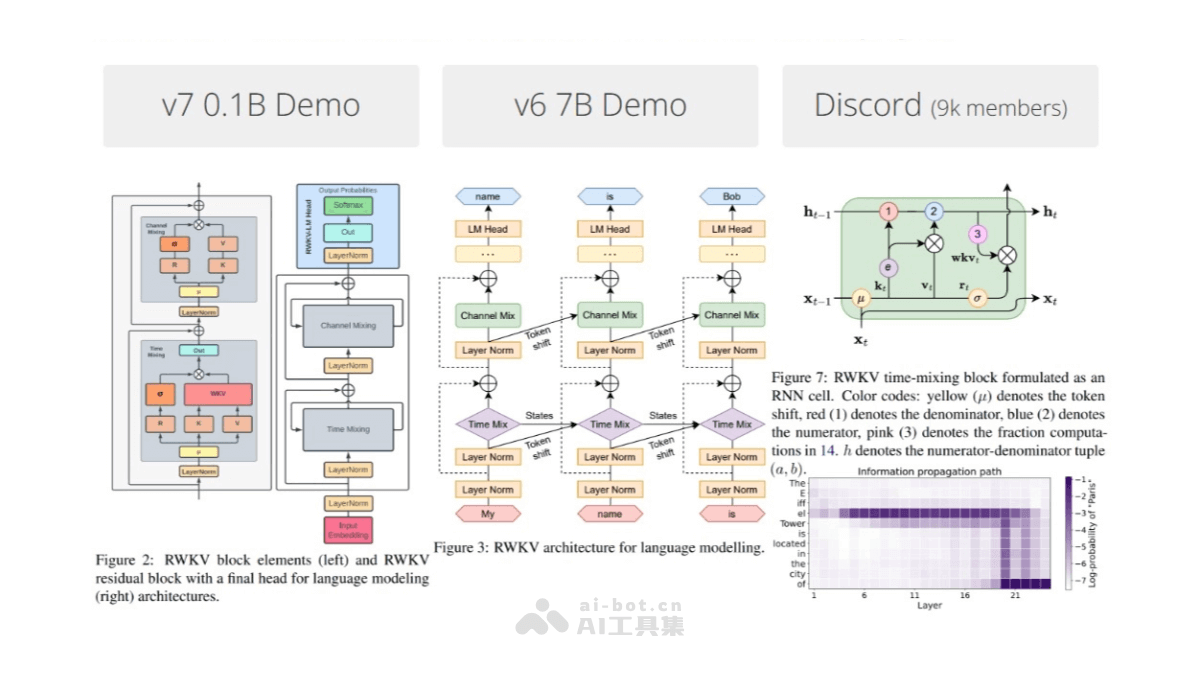

RWKV-7是RWKV系列的最新大模型架构版本,超越了传统的attention和linear attention范式,具有更灵活的状态演化能力,能在相同算力消耗下解决attention无法解决的问题。RWKV-7的研究始于2024年9月,预览版RWKV-7 "Goose" x070.rc2-2409-2r7a-b0b4a的训练代码首次提交于RWKV-LM仓库的commit中。其核心优势在于强大的ICL(In-context Learning)能力,以及训练过程中的稳定性和效率。RWKV-7架构已确认使用”rc4a”版本作为最终代码,已经发布了0.1B和0.4B两种参数的模型。RWKV-7的研究和开发是一个活跃的领域,不断有新的进展和模型发布。

RWKV-7的主要功能超越传统Attention机制:RWKV-7架构超越了传统的attention和linear attention范式,具有更灵活的状态演化能力,能在相同算力消耗下解决attention无法解决的问题。动态学习策略:RWKV-7通过使用加权关键值(WKV)机制,能高效地处理信息,在学习过程中灵活调整策略。动态状态更新:RWKV-7的动态状态更新公式允许模型在每个时间步都保留重要的信息,同时适应新的输入。学习率的动态调整:RWKV-7通过特定的公式实现学习率的动态调整,有效控制学习率,使模型在学习过程中更加稳定。上下文学习率:RWKV-7引入了“上下文学习率”的概念,支持模型在不同的上下文中自适应地调整学习率,增强了模型在多变环境中的灵活性和学习效率。高效的推理速度和低显存占用:RWKV-7能处理无限上下文,非常适合长文本处理和多轮对话等应用,且对硬件友好,仅执行矩阵与矢量的乘法操作,无需KV缓存。RNN-like推理:RWKV-7基于递归网络结构,在推理阶段可以方便地以递归形式进行解码。额外优化:RWKV-7包括小初始化嵌入和自定义初始化等优化策略,以加速和稳定训练过程,并在更深的架构中实现更好的收敛性。RWKV-7的项目地址项目官网:rwkv.comGithub仓库:https://github.com/BlinkDL/RWKV-LM/tree/main/RWKV-v7RWKV-7的评测效果训练效率和稳定性:RWKV-7的训练Loss更低,且训练非常稳定,相比RWKV-6有显著改进。多语言模型性能:RWKV-7-World-0.1B是目前全球最强的0.1B多语言模型,在英文和多语言基准评测中表现出色,多语言能力显著超越所有同尺寸模型。模型设计优势:RWKV-7-World-0.1B-v2.8保持L12-D768的架构设计,更少的神经网络层数使得RWKV-7的速度更快,更适合边缘设备等资源受限的推理场景。推理成本降低:基于RWKV-v5架构的Eagle 7B模型在推理成本上降低了10-100倍,这表明RWKV架构在效率上具有显著优势。多语言基准测试:Eagle 7B在多语言基准测试中优于所有的7B类模型,显示了RWKV架构在多语言处理上的强大能力。英语评测性能:在英语评测中,Eagle 7B性能接近Falcon (1.5T)、LLaMA2 (2T)、Mistral,与MPT-7B (1T)相当,显示了RWKV架构在英语任务上的强大性能。RWKV-7的应用场景文本生成:RWKV-7能生成流畅、连贯的文本,特别适用于小说写作、诗歌创作等创意性任务。机器翻译:RWKV-7能处理长句和复杂语法结构,提高机器翻译的准确性和流畅性。情感分析:RWKV-7能深入理解文本中的情感倾向,为电商、社交等领域提供精准的情感分析服务。对话系统:RWKV-7能保持长时间的上下文记忆,为对话系统提供更加自然、连贯的交互体验。多语言处理:RWKV-7模型在多语言任务上表现良好,特别是在中文、日文等非英语语言上的效果优于许多开源模型。代码生成:RWKV-7在程序代码生成任务上也有不错的表现,可用于辅助编程。

RWKV-7的主要功能超越传统Attention机制:RWKV-7架构超越了传统的attention和linear attention范式,具有更灵活的状态演化能力,能在相同算力消耗下解决attention无法解决的问题。动态学习策略:RWKV-7通过使用加权关键值(WKV)机制,能高效地处理信息,在学习过程中灵活调整策略。动态状态更新:RWKV-7的动态状态更新公式允许模型在每个时间步都保留重要的信息,同时适应新的输入。学习率的动态调整:RWKV-7通过特定的公式实现学习率的动态调整,有效控制学习率,使模型在学习过程中更加稳定。上下文学习率:RWKV-7引入了“上下文学习率”的概念,支持模型在不同的上下文中自适应地调整学习率,增强了模型在多变环境中的灵活性和学习效率。高效的推理速度和低显存占用:RWKV-7能处理无限上下文,非常适合长文本处理和多轮对话等应用,且对硬件友好,仅执行矩阵与矢量的乘法操作,无需KV缓存。RNN-like推理:RWKV-7基于递归网络结构,在推理阶段可以方便地以递归形式进行解码。额外优化:RWKV-7包括小初始化嵌入和自定义初始化等优化策略,以加速和稳定训练过程,并在更深的架构中实现更好的收敛性。RWKV-7的项目地址项目官网:rwkv.comGithub仓库:https://github.com/BlinkDL/RWKV-LM/tree/main/RWKV-v7RWKV-7的评测效果训练效率和稳定性:RWKV-7的训练Loss更低,且训练非常稳定,相比RWKV-6有显著改进。多语言模型性能:RWKV-7-World-0.1B是目前全球最强的0.1B多语言模型,在英文和多语言基准评测中表现出色,多语言能力显著超越所有同尺寸模型。模型设计优势:RWKV-7-World-0.1B-v2.8保持L12-D768的架构设计,更少的神经网络层数使得RWKV-7的速度更快,更适合边缘设备等资源受限的推理场景。推理成本降低:基于RWKV-v5架构的Eagle 7B模型在推理成本上降低了10-100倍,这表明RWKV架构在效率上具有显著优势。多语言基准测试:Eagle 7B在多语言基准测试中优于所有的7B类模型,显示了RWKV架构在多语言处理上的强大能力。英语评测性能:在英语评测中,Eagle 7B性能接近Falcon (1.5T)、LLaMA2 (2T)、Mistral,与MPT-7B (1T)相当,显示了RWKV架构在英语任务上的强大性能。RWKV-7的应用场景文本生成:RWKV-7能生成流畅、连贯的文本,特别适用于小说写作、诗歌创作等创意性任务。机器翻译:RWKV-7能处理长句和复杂语法结构,提高机器翻译的准确性和流畅性。情感分析:RWKV-7能深入理解文本中的情感倾向,为电商、社交等领域提供精准的情感分析服务。对话系统:RWKV-7能保持长时间的上下文记忆,为对话系统提供更加自然、连贯的交互体验。多语言处理:RWKV-7模型在多语言任务上表现良好,特别是在中文、日文等非英语语言上的效果优于许多开源模型。代码生成:RWKV-7在程序代码生成任务上也有不错的表现,可用于辅助编程。