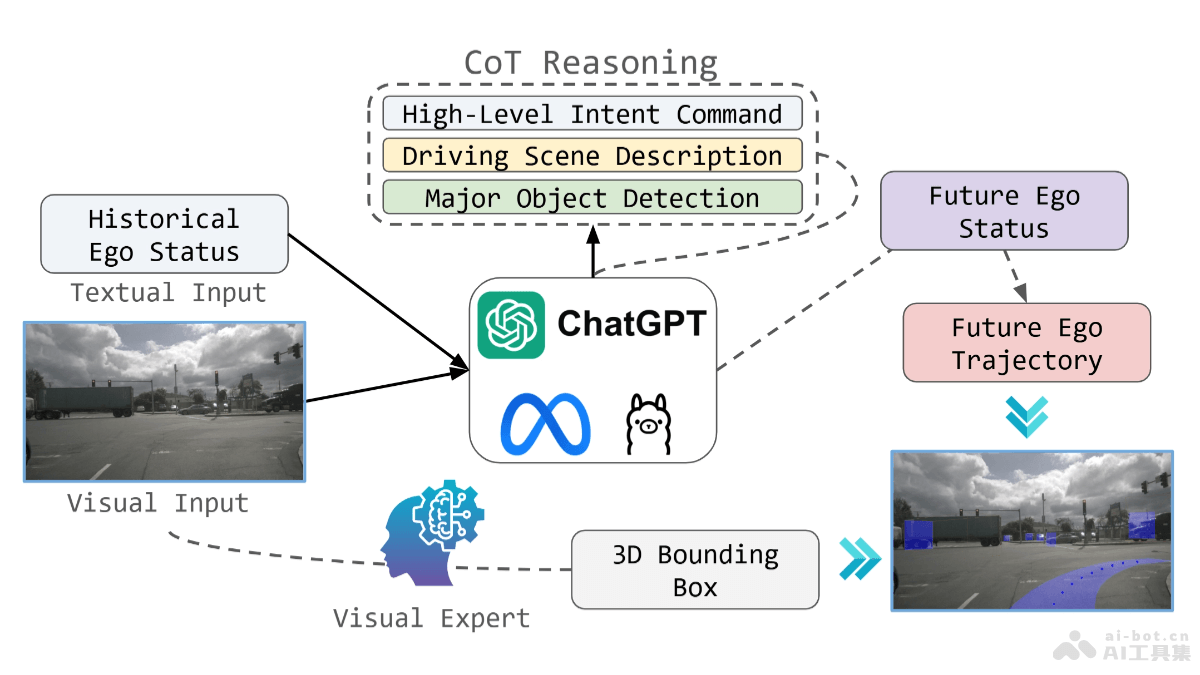

OpenEMMA是德州农工大学、密歇根大学和多伦多大学共同开源的端到端自动驾驶多模态模型框架,基于预训练的多模态大型语言模型(MLLMs)处理视觉数据和复杂驾驶场景的推理。框架基于链式思维推理过程,显著提高模型在轨迹规划和感知任务中的性能,同时集成专门优化的YOLO模型提高3D边界框预测的准确性。OpenEMMA提供了一个平台,促进更广泛的研究和开发,推动自动驾驶技术的进步。

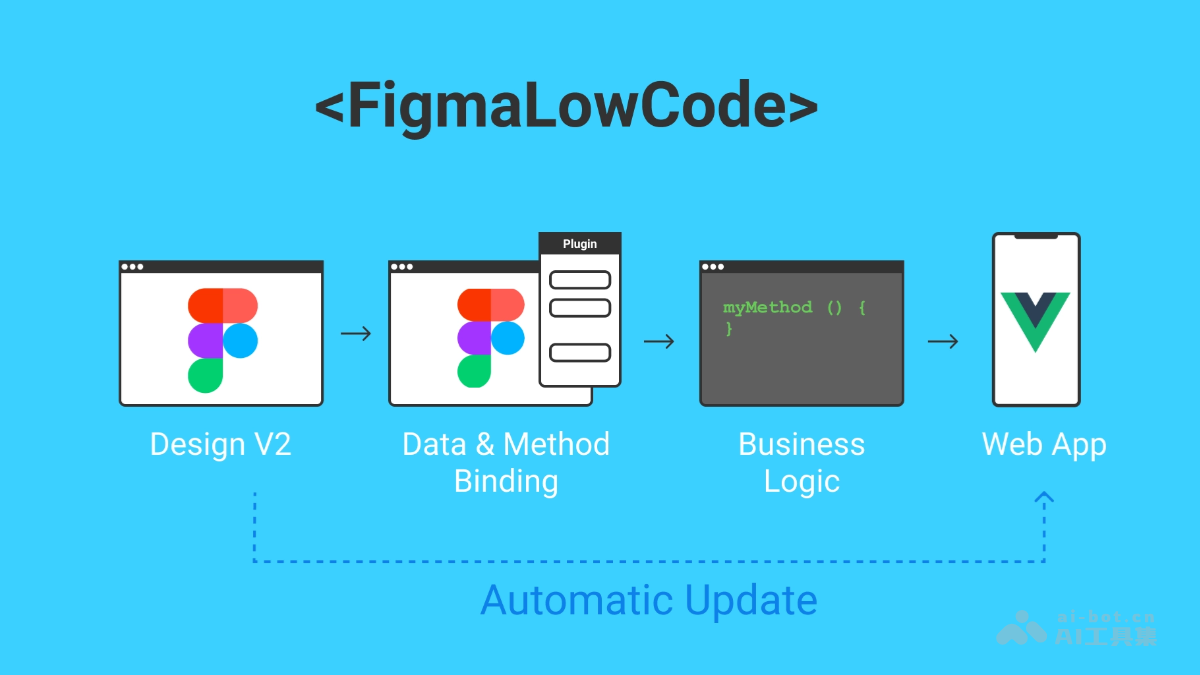

OpenEMMA的主要功能端到端轨迹规划:直接从传感器输入学习驾驶动作,实现从感知到决策的端到端优化,无需符号化接口。多模态数据处理:框架处理前向摄像头图像和文本历史 ego 车辆状态作为输入,将驾驶任务框架化为视觉问答(VQA)问题。链式思维推理:采用链式思维推理过程,指导模型生成关键对象的详细描述、行为洞察和元驾驶决策。3D对象检测:集成微调的YOLO模型,OpenEMMA能精确检测3D道路上的对象,提高对象检测的准确性。人类可读输出:基于MLLM的预存世界知识,OpenEMMA能为场景理解等感知任务产生可解释的、人类可读的输出。OpenEMMA的技术原理预训练的MLLMs:基于预训练的MLLMs,处理复杂的视觉数据,推理驾驶场景。链式思维推理过程:基于链式思维推理,模型能生成速度向量和曲率向量,向量用在计算车辆的未来轨迹。速度和曲率向量:给定速度和曲率向量,模型首先整合每个时间步的航向角,然后计算速度的x和y分量,最终用积分速度分量计算最终轨迹。对象检测增强:为克服MLLMs在空间推理上的局限,集成一个专门优化用在3D边界框预测的YOLO模型。端到端规划与推理:OpenEMMA遵循基于指令的方法,提示MLLMs产生人类可解释的知识,将轨迹生成任务分解为人类可解释的组成部分,反映驾驶过程。OpenEMMA的项目地址GitHub仓库:https://github.com/taco-group/OpenEMMAarXiv技术论文:https://arxiv.org/pdf/2412.15208OpenEMMA的应用场景城市道路驾驶:在复杂的城市交通环境中,处理多变的交通信号、行人、自行车和其他车辆,为自动驾驶车辆提供实时决策和轨迹规划。高速公路驾驶:在高速公路上,处理高速行驶中的车辆,进行车道保持、超车、避障等操作的决策支持。停车和低速驾驶:在停车场或低速环境中,帮助自动驾驶车辆进行精确的停车操作,避免障碍物,能在狭小空间中导航。夜间驾驶:OpenEMMA能在低光照条件下工作,提供夜间驾驶时的决策支持,包括对象检测和轨迹规划。复杂天气条件:在雨、雾等复杂天气条件下,辅助自动驾驶车辆保持安全行驶,减少天气对驾驶的影响。

OpenEMMA的主要功能端到端轨迹规划:直接从传感器输入学习驾驶动作,实现从感知到决策的端到端优化,无需符号化接口。多模态数据处理:框架处理前向摄像头图像和文本历史 ego 车辆状态作为输入,将驾驶任务框架化为视觉问答(VQA)问题。链式思维推理:采用链式思维推理过程,指导模型生成关键对象的详细描述、行为洞察和元驾驶决策。3D对象检测:集成微调的YOLO模型,OpenEMMA能精确检测3D道路上的对象,提高对象检测的准确性。人类可读输出:基于MLLM的预存世界知识,OpenEMMA能为场景理解等感知任务产生可解释的、人类可读的输出。OpenEMMA的技术原理预训练的MLLMs:基于预训练的MLLMs,处理复杂的视觉数据,推理驾驶场景。链式思维推理过程:基于链式思维推理,模型能生成速度向量和曲率向量,向量用在计算车辆的未来轨迹。速度和曲率向量:给定速度和曲率向量,模型首先整合每个时间步的航向角,然后计算速度的x和y分量,最终用积分速度分量计算最终轨迹。对象检测增强:为克服MLLMs在空间推理上的局限,集成一个专门优化用在3D边界框预测的YOLO模型。端到端规划与推理:OpenEMMA遵循基于指令的方法,提示MLLMs产生人类可解释的知识,将轨迹生成任务分解为人类可解释的组成部分,反映驾驶过程。OpenEMMA的项目地址GitHub仓库:https://github.com/taco-group/OpenEMMAarXiv技术论文:https://arxiv.org/pdf/2412.15208OpenEMMA的应用场景城市道路驾驶:在复杂的城市交通环境中,处理多变的交通信号、行人、自行车和其他车辆,为自动驾驶车辆提供实时决策和轨迹规划。高速公路驾驶:在高速公路上,处理高速行驶中的车辆,进行车道保持、超车、避障等操作的决策支持。停车和低速驾驶:在停车场或低速环境中,帮助自动驾驶车辆进行精确的停车操作,避免障碍物,能在狭小空间中导航。夜间驾驶:OpenEMMA能在低光照条件下工作,提供夜间驾驶时的决策支持,包括对象检测和轨迹规划。复杂天气条件:在雨、雾等复杂天气条件下,辅助自动驾驶车辆保持安全行驶,减少天气对驾驶的影响。