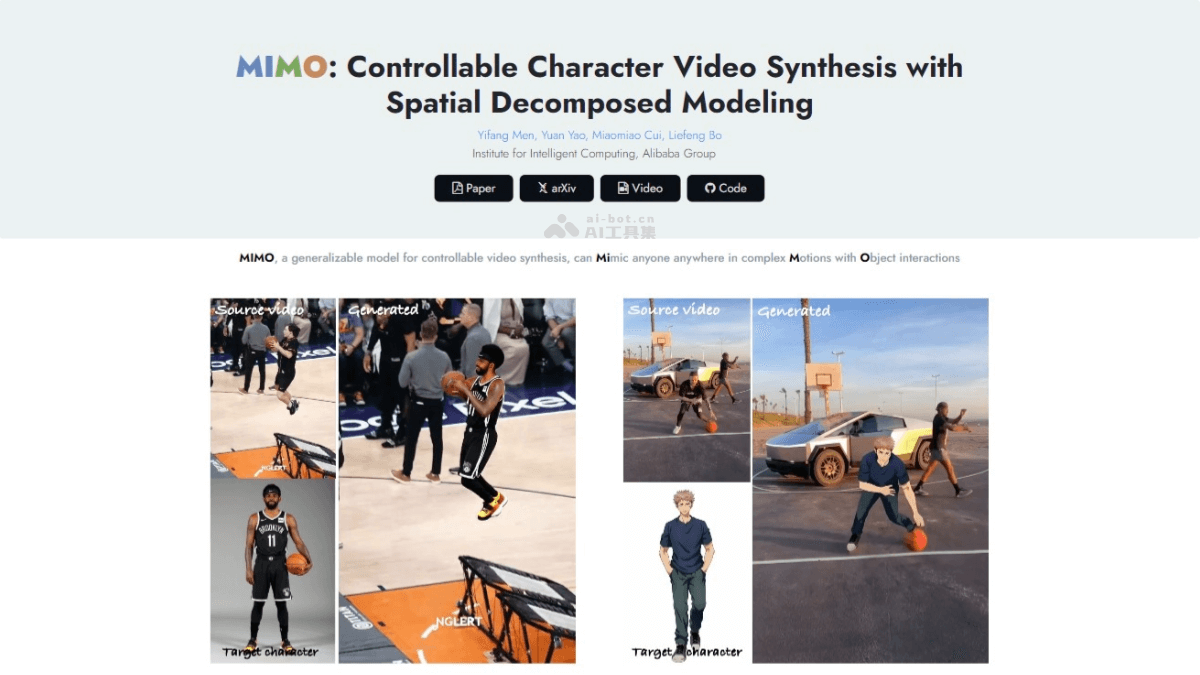

MIMO是阿里巴巴集团智能计算研究所推出的可控角色视频合成的新型AI框架,基于空间分解建模技术,将2D视频转换为3D空间代码,实现对角色、动作和场景的精确控制。MIMO能处理任意角色的合成,适应新颖的3D动作,并与真实世界场景交互。MIMO的核心在于将视频分解为主要人物、底层场景和浮动遮挡三个部分,然后分别编码为身份代码、运动代码和场景代码,用于合成过程的控制信号。不仅提高了合成视频的真实感,还增强了用户对视频内容的控制能力。

MIMO的主要功能可控角色合成:用户通过提供简单的输入控制视频中角色的外观。动作控制:MIMO能根据提供的姿势序列合成角色的动作,包括复杂的3D动作。场景交互:将角色自然地融入到真实世界的场景中,包括处理遮挡和物体交互。空间分解建模:将视频分解为不同的空间组件,包括主要人物、底层场景和浮动遮挡。3D感知合成:基于3D表示提高合成视频的真实感和深度感知。灵活的用户控制:用户自由组合不同的潜在代码控制视频合成的各个方面。任意角色的可扩展性:MIMO能合成任意角色,不仅限于训练数据集中的角色。MIMO的技术原理3D深度估计:用单目深度估计器将2D视频帧转换成3D空间中的表示。空间分解:基于估计的3D深度信息,将视频分解为三个主要的空间组件:主要人物:视频中的核心对象。底层场景:视频的背景部分。浮动遮挡:视频中的前景物体,如会遮挡主体的物体。组件编码:将上述空间组件进一步编码为不同的代码:身份代码:表示角色的视觉身份。运动代码:表示角色的动作和姿态。场景代码:表示视频的背景场景信息。结构化运动表示:用变形的人体模型(如SMPL)表示和编码人物的动作,允许更精确地捕捉复杂的3D运动。规范身份表示:将角色转换到一个规范的姿势(如A-pose)解耦身份和动作,使身份表示与动作无关。场景和遮挡编码:用共享的变分自编码器(VAE)编码场景和遮挡组件,然后重新组织为完整的场景代码。MIMO的项目地址项目官网:menyifang.github.io/projects/MIMO/index.htmlGitHub仓库:https://github.com/menyifang/MIMOarXiv技术论文:https://arxiv.org/pdf/2409.16160MIMO的应用场景电影和视频制作:快速生成动画角色的表演,减少特效和动画制作的成本和时间。游戏开发:为游戏角色创建逼真的动作和交互,提升游戏体验。虚拟现实(VR):在虚拟环境中创建与用户互动的动态角色,增强沉浸感。增强现实(AR):在现实世界中叠加虚拟角色和对象,用于教育、娱乐或导航。社交媒体和娱乐:允许用户创建和分享具有个性化动作和场景的虚拟角色视频。广告和营销:制作吸引人的动态广告,其中角色根据目标受众进行定制。教育和培训:创建模拟场景和角色,用于教育目的,如历史重现或语言学习。

MIMO的主要功能可控角色合成:用户通过提供简单的输入控制视频中角色的外观。动作控制:MIMO能根据提供的姿势序列合成角色的动作,包括复杂的3D动作。场景交互:将角色自然地融入到真实世界的场景中,包括处理遮挡和物体交互。空间分解建模:将视频分解为不同的空间组件,包括主要人物、底层场景和浮动遮挡。3D感知合成:基于3D表示提高合成视频的真实感和深度感知。灵活的用户控制:用户自由组合不同的潜在代码控制视频合成的各个方面。任意角色的可扩展性:MIMO能合成任意角色,不仅限于训练数据集中的角色。MIMO的技术原理3D深度估计:用单目深度估计器将2D视频帧转换成3D空间中的表示。空间分解:基于估计的3D深度信息,将视频分解为三个主要的空间组件:主要人物:视频中的核心对象。底层场景:视频的背景部分。浮动遮挡:视频中的前景物体,如会遮挡主体的物体。组件编码:将上述空间组件进一步编码为不同的代码:身份代码:表示角色的视觉身份。运动代码:表示角色的动作和姿态。场景代码:表示视频的背景场景信息。结构化运动表示:用变形的人体模型(如SMPL)表示和编码人物的动作,允许更精确地捕捉复杂的3D运动。规范身份表示:将角色转换到一个规范的姿势(如A-pose)解耦身份和动作,使身份表示与动作无关。场景和遮挡编码:用共享的变分自编码器(VAE)编码场景和遮挡组件,然后重新组织为完整的场景代码。MIMO的项目地址项目官网:menyifang.github.io/projects/MIMO/index.htmlGitHub仓库:https://github.com/menyifang/MIMOarXiv技术论文:https://arxiv.org/pdf/2409.16160MIMO的应用场景电影和视频制作:快速生成动画角色的表演,减少特效和动画制作的成本和时间。游戏开发:为游戏角色创建逼真的动作和交互,提升游戏体验。虚拟现实(VR):在虚拟环境中创建与用户互动的动态角色,增强沉浸感。增强现实(AR):在现实世界中叠加虚拟角色和对象,用于教育、娱乐或导航。社交媒体和娱乐:允许用户创建和分享具有个性化动作和场景的虚拟角色视频。广告和营销:制作吸引人的动态广告,其中角色根据目标受众进行定制。教育和培训:创建模拟场景和角色,用于教育目的,如历史重现或语言学习。