QVQ是阿里基于Qwen2-VL-72B构建的开源多模态推理模型,结合视觉理解和复杂问题解决能力,提升人工智能的认知能力。QVQ在视觉推理任务中展现出增强的能力,尤其在需要复杂分析思维的领域表现出色。QVQ在MMMU评测中取得了70.3的高分,在各项数学相关基准测试中相比Qwen2-VL-72B-Instruct 有显著提升。QVQ致力实现全能和智能的模型,能深度思考和推理,应对复杂挑战,参与科学探索。

QVQ的主要功能多模态推理:QVQ能处理和理解文本、图像等多种类型的数据,实现跨模态的信息融合和推理。视觉理解:具备对视觉信息的解析能力,能理解和分析图像内容。复杂问题解决:QVQ能处理需要复杂逻辑和分析的问题,尤其是在数学和科学领域。逐步推理:进行细致的逐步推理,适合解决需要深入分析的问题。QVQ的项目地址项目官网:qwenlm.github.io/zh/blog/qvq-72b-previewHuggingFace模型库:https://huggingface.co/Qwen/QVQ-72B-PreviewQVQ的局限性

QVQ的主要功能多模态推理:QVQ能处理和理解文本、图像等多种类型的数据,实现跨模态的信息融合和推理。视觉理解:具备对视觉信息的解析能力,能理解和分析图像内容。复杂问题解决:QVQ能处理需要复杂逻辑和分析的问题,尤其是在数学和科学领域。逐步推理:进行细致的逐步推理,适合解决需要深入分析的问题。QVQ的项目地址项目官网:qwenlm.github.io/zh/blog/qvq-72b-previewHuggingFace模型库:https://huggingface.co/Qwen/QVQ-72B-PreviewQVQ的局限性QVQ-72B-Preview 是 Qwen 团队推出的实验性研究模型,专注于增强视觉推理能力。尽管表现超出了预期,有几个限制需要注意:

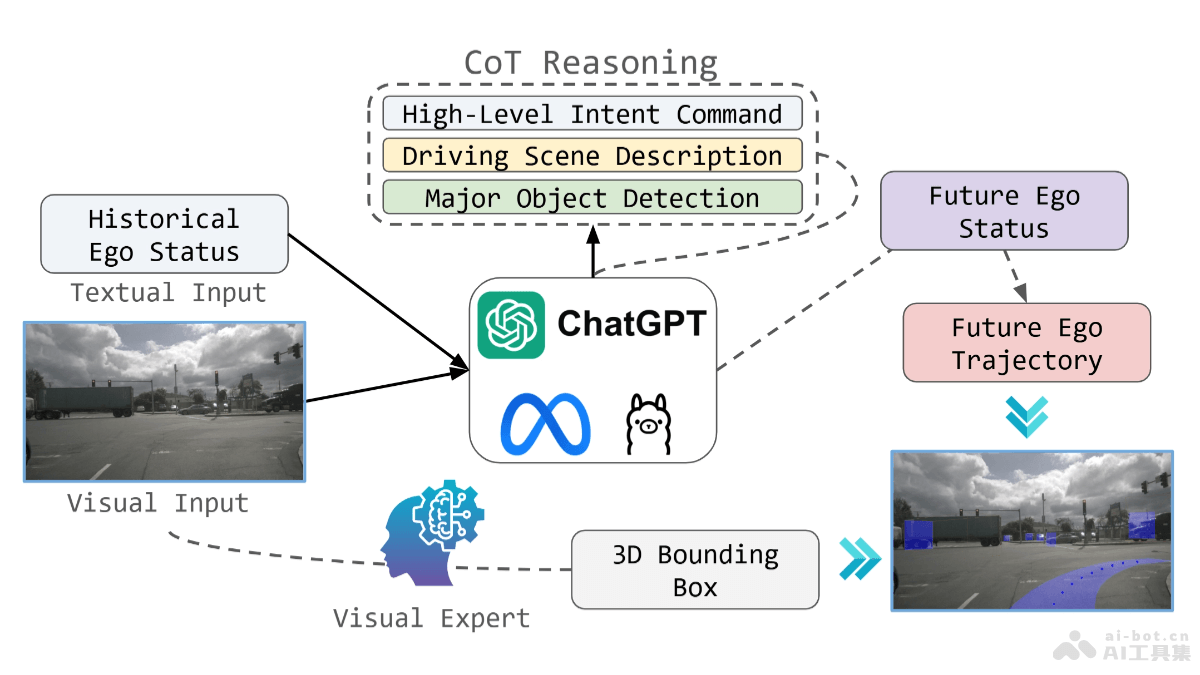

语言混合和代码切换问题:模型可能会意外的在不同语言之间切换,影响输出的清晰度和准确性。递归推理问题:模型可能会陷入循环逻辑模式,导致冗长的响应而无法得出有效结论。安全和伦理考虑:模型需要增强安全措施,确保可靠和安全的性能。用户在部署时应保持谨慎,确保模型的输出符合伦理和安全标准。性能和基准限制:尽管模型在视觉推理方面有所改善,但无法完全替代Qwen2-VL-72B的能力。在多步骤视觉推理过程中,模型可能会逐渐失去对图像内容的关注,导致幻觉。QVQ的应用场景教育和学习辅助:提供个性化的学习体验,帮助学生理解复杂的概念,如数学问题和科学实验。自动驾驶汽车:处理和解释来自车载摄像头的视觉数据,做出驾驶决策。医疗图像分析:辅助医生分析医学影像,如X光片、CT扫描和MRI,诊断疾病。安全监控:分析监控视频,识别异常行为或潜在的安全威胁。客户服务:通过聊天机器人提供多语言支持,理解和回应客户查询。