MMBench-Video是新颖的长视频多题问答基准测试,是浙江大学、上海人工智能实验室、上海交通大学和香港中文大学联合推出的。MMBench-Video能全面评估大型视觉语言模型(LVLMs)在视频理解方面的能力,用包含丰富视频内容和细粒度能力评估的长视频,弥补现有基准测试在时序理解和复杂任务处理方面的不足。MMBench-Video包含约600个YouTube视频片段,覆盖16个类别,每个视频时长从30秒到6分钟不等,配有由志愿者编写的高质量问答对。基准测试用GPT-4进行自动化评估,提高准确性,与人类判断保持一致。MMBench-Video的推出为研究人员提供了强大的工具,评估和改进视频语言模型的能力。

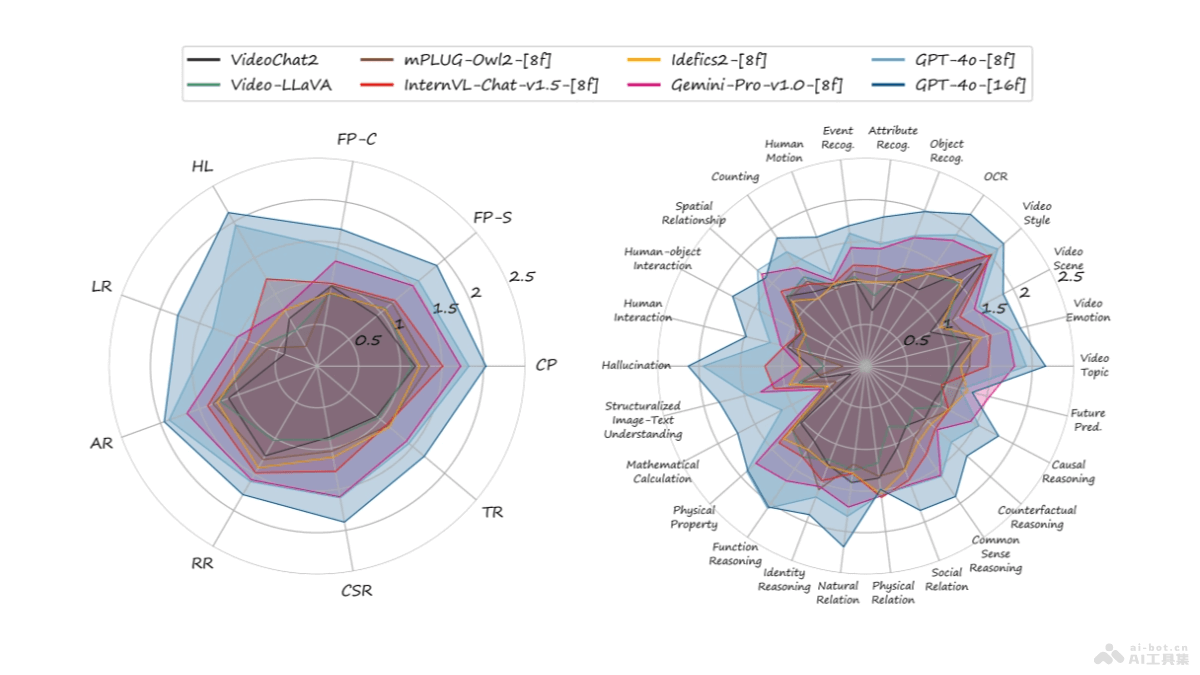

MMBench-Video的主要功能视频理解评估:MMBench-Video用在评估大型视觉语言模型(LVLMs)在理解长视频内容方面的能力。多场景覆盖:包含16个主要类别的视频内容,涵盖广泛的主题和场景。细粒度能力评估:用26个细粒度的能力维度,对模型的视频理解能力进行详尽评估。高质量数据集:视频片段和问答对均由志愿者精心编写和标注,确保数据质量。自动化评估:用GPT-4进行自动化的评估,提高评估的效率和准确性。MMBench-Video的技术原理长视频内容:MMBench-Video包含从YouTube采集的多个长视频片段,视频片段比传统短视频更能测试模型的时序理解能力。人工标注:问题和答案对均由人类志愿者编写和标注,确保高质量和减少偏差。能力分类体系:构建三层级的视频理解能力分类体系,包括感知和推理两大类,及更细分的26个能力维度。时序推理挑战:设计需要时序推理能力的问题,评估模型对视频内容时间维度的理解。自动化评估:语言模型(如GPT-4)自动化评估模型输出与标准答案之间的语义相似度,评估模型的性能。多模型比较:支持对多个LVLMs进行评分和比较,确定在视频理解任务上的优势和不足。MMBench-Video的项目地址项目官网:mmbench-video.github.ioGitHub仓库:https://github.com/open-compass/VLMEvalKitHuggingFace模型库:https://huggingface.co/datasets/opencompass/MMBench-VideoarXiv技术论文:https://arxiv.org/pdf/2406.14515MMBench-Video的应用场景模型评估与比较:研究人员评估和比较不同的LVLMs在视频理解方面的能力,包括感知和推理技能。模型优化与训练:开发者根据MMBench-Video的评估结果优化模型的架构和训练过程,提高模型对视频内容的理解能力。学术交流与发表:作为学术交流的工具,帮助研究人员展示模型的性能,在学术会议或期刊上发表相关研究成果。多模态学习研究:MMBench-Video提供丰富的数据集,研究和开发多模态学习算法,特别是涉及视频和文本理解的任务。智能视频分析应用:在智能视频监控、内容过滤、自动摘要和视频推荐等领域,帮助开发者训练和测试更加精准的视频分析模型。

MMBench-Video的主要功能视频理解评估:MMBench-Video用在评估大型视觉语言模型(LVLMs)在理解长视频内容方面的能力。多场景覆盖:包含16个主要类别的视频内容,涵盖广泛的主题和场景。细粒度能力评估:用26个细粒度的能力维度,对模型的视频理解能力进行详尽评估。高质量数据集:视频片段和问答对均由志愿者精心编写和标注,确保数据质量。自动化评估:用GPT-4进行自动化的评估,提高评估的效率和准确性。MMBench-Video的技术原理长视频内容:MMBench-Video包含从YouTube采集的多个长视频片段,视频片段比传统短视频更能测试模型的时序理解能力。人工标注:问题和答案对均由人类志愿者编写和标注,确保高质量和减少偏差。能力分类体系:构建三层级的视频理解能力分类体系,包括感知和推理两大类,及更细分的26个能力维度。时序推理挑战:设计需要时序推理能力的问题,评估模型对视频内容时间维度的理解。自动化评估:语言模型(如GPT-4)自动化评估模型输出与标准答案之间的语义相似度,评估模型的性能。多模型比较:支持对多个LVLMs进行评分和比较,确定在视频理解任务上的优势和不足。MMBench-Video的项目地址项目官网:mmbench-video.github.ioGitHub仓库:https://github.com/open-compass/VLMEvalKitHuggingFace模型库:https://huggingface.co/datasets/opencompass/MMBench-VideoarXiv技术论文:https://arxiv.org/pdf/2406.14515MMBench-Video的应用场景模型评估与比较:研究人员评估和比较不同的LVLMs在视频理解方面的能力,包括感知和推理技能。模型优化与训练:开发者根据MMBench-Video的评估结果优化模型的架构和训练过程,提高模型对视频内容的理解能力。学术交流与发表:作为学术交流的工具,帮助研究人员展示模型的性能,在学术会议或期刊上发表相关研究成果。多模态学习研究:MMBench-Video提供丰富的数据集,研究和开发多模态学习算法,特别是涉及视频和文本理解的任务。智能视频分析应用:在智能视频监控、内容过滤、自动摘要和视频推荐等领域,帮助开发者训练和测试更加精准的视频分析模型。