HourVideo是斯坦福大学李飞飞和吴佳俊团队推出的长视频理解基准数据集,包含500个第一人称视角视频,时长20至120分钟,覆盖77种日常活动,能评估多模态模型对长视频的理解能力。数据集基于一系列任务,如总结、感知、视觉推理和导航,测试模型对视频中多个时间片段信息的识别和综合能力,推动长视频理解技术的发展。

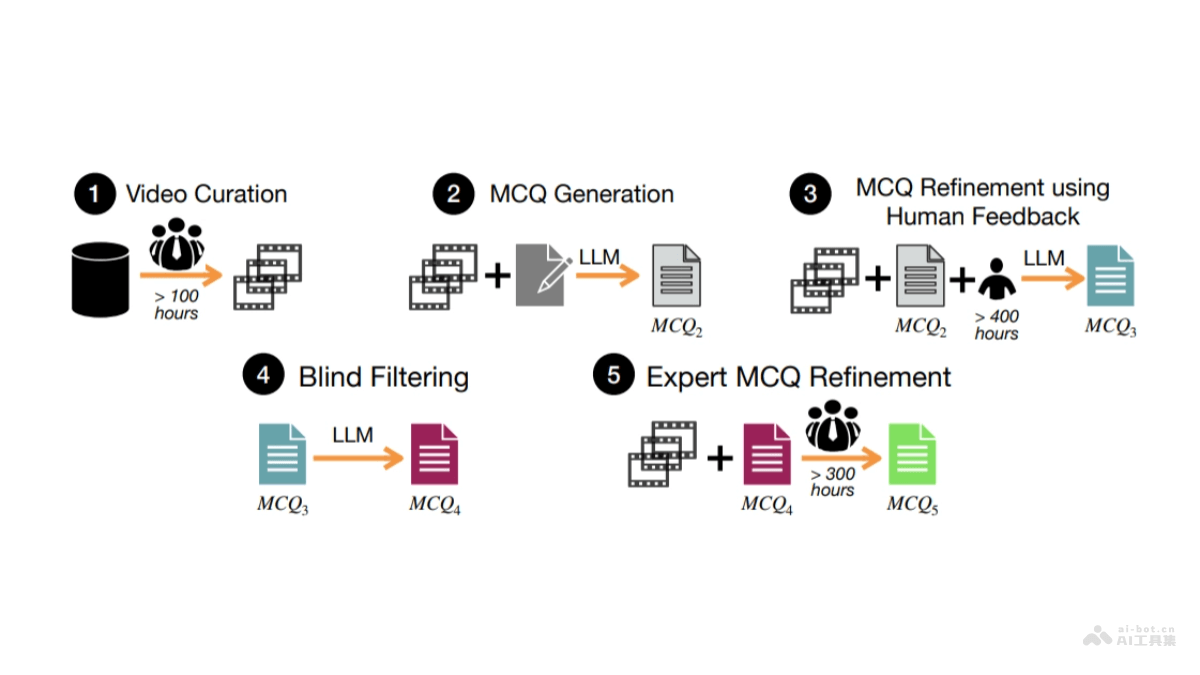

HourVideo的主要功能长视频理解评估:基于包含长达一小时的视频,HourVideo能测试模型对长时间视觉数据流的理解能力。多任务测试套件:数据集包含多种任务,如总结、感知、视觉推理和导航,全面评估模型在不同视频语言理解方面的表现。高质量问题生成:基于人工注释者和大型语言模型(LLMs)生成的12,976个多项选择题,提供标准化的测试题目。模型性能比较:与其他多模态模型的比较,评估不同模型在长视频理解任务上的性能。HourVideo的技术原理视频数据集构建:HourVideo从Ego4D数据集中筛选出500个第一人称视角视频,覆盖日常活动,视频时长从20到120分钟不等。任务套件设计:设计一套包含多个子任务的任务套件,每个任务需要模型对视频内容进行长期依赖关系的理解和推理。问题原型开发:为每个任务设计问题原型,确保正确回答问题需要对视频的多个时间片段进行信息识别和综合。数据生成流程:基于一个多阶段的数据生成流程,包括视频筛选、问题生成、人工反馈优化、盲筛选和专家优化,生成高质量的多项选择题。HourVideo的项目地址arXiv技术论文:https://arxiv.org/pdf/2411.04998v1HourVideo的应用场景多模态人工智能研究:研究和开发理解长时间连续视频内容的多模态模型。自主代理和助手系统:帮助开发理解长时间视觉信息并做出决策的自主代理和虚拟助手。增强现实(AR)和虚拟现实(VR):提供技术基础,创建能理解和适应用户行为的沉浸式AR/VR体验。视频内容分析:分析和理解视频内容,如监控视频、新闻报道、教育视频等,提取关键信息和洞察。机器人视觉:让机器人能理解长时间序列的视觉信息,提高其在复杂环境中的导航和操作能力。

HourVideo的主要功能长视频理解评估:基于包含长达一小时的视频,HourVideo能测试模型对长时间视觉数据流的理解能力。多任务测试套件:数据集包含多种任务,如总结、感知、视觉推理和导航,全面评估模型在不同视频语言理解方面的表现。高质量问题生成:基于人工注释者和大型语言模型(LLMs)生成的12,976个多项选择题,提供标准化的测试题目。模型性能比较:与其他多模态模型的比较,评估不同模型在长视频理解任务上的性能。HourVideo的技术原理视频数据集构建:HourVideo从Ego4D数据集中筛选出500个第一人称视角视频,覆盖日常活动,视频时长从20到120分钟不等。任务套件设计:设计一套包含多个子任务的任务套件,每个任务需要模型对视频内容进行长期依赖关系的理解和推理。问题原型开发:为每个任务设计问题原型,确保正确回答问题需要对视频的多个时间片段进行信息识别和综合。数据生成流程:基于一个多阶段的数据生成流程,包括视频筛选、问题生成、人工反馈优化、盲筛选和专家优化,生成高质量的多项选择题。HourVideo的项目地址arXiv技术论文:https://arxiv.org/pdf/2411.04998v1HourVideo的应用场景多模态人工智能研究:研究和开发理解长时间连续视频内容的多模态模型。自主代理和助手系统:帮助开发理解长时间视觉信息并做出决策的自主代理和虚拟助手。增强现实(AR)和虚拟现实(VR):提供技术基础,创建能理解和适应用户行为的沉浸式AR/VR体验。视频内容分析:分析和理解视频内容,如监控视频、新闻报道、教育视频等,提取关键信息和洞察。机器人视觉:让机器人能理解长时间序列的视觉信息,提高其在复杂环境中的导航和操作能力。