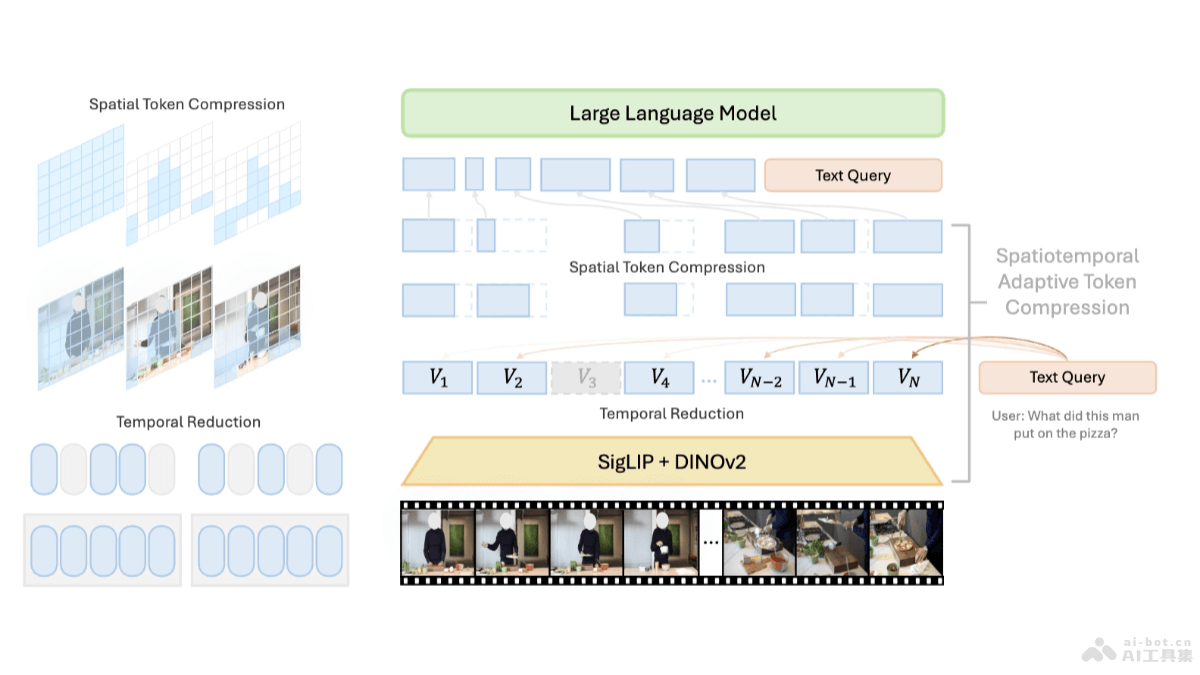

LongVU是Meta AI团队推出的长视频理解模型,基于时空自适应压缩机制。解决处理长视频时受限于大型语言模型(LLM)上下文大小的挑战。LongVU基于跨模态查询和帧间依赖性,LongVU能在减少视频标记数量的同时,保留长视频的视觉细节。LongVU用DINOv2特征去除相似度高的冗余帧,用文本引导的跨模态查询进行选择性帧特征减少,在必要时基于时间依赖性进行空间标记压缩。LongVU能有效处理大量帧,在给定的上下文长度内损失很少的视觉信息。

LongVU的主要功能时空自适应压缩:LongVU基于减少视频标记的数量来处理长视频,保留视频中的关键视觉细节,能在有限的上下文长度内处理非常长的的视频内容。跨模态查询:基于文本引导的跨模态查询来选择性地减少视频帧的特征,能保留与文本查询最相关的帧的详细信息,将其他帧减少到低分辨率的标记表示。帧间依赖性利用:基于分析视频帧之间的时间依赖性,LongVU能基于依赖性执行空间标记的压缩,减少模型的上下文长度需求。长视频理解:LongVU能有效处理1fps采样的视频输入,且能适应性地将每小时长视频的平均每个帧的标记数量减少到2个,适应8k上下文长度的多模态大型语言模型(MLLM)。LongVU的技术原理时间压缩策略:用DINOv2特征识别、去除高度相似的冗余视频帧,减少视频的时间维度上的冗余。选择性特征降低:基于文本引导的跨模态查询,对与文本查询相关的帧保留完整的标记(tokens),对其他帧应用空间池化,减少空间维度上的冗余。空间标记压缩:对于极长的视频,LongVU基于帧之间的时间依赖性进一步压缩空间标记。用计算帧间的空间标记相似性,剔除与首帧相似度过高的后续帧的空间标记,减少模型需要处理的数据量。多模态训练:LongVU结合图像-语言预训练和视频-语言微调,用大规模视频-文本对进行训练,提升模型在视频理解任务中的表现。LongVU的项目地址项目官网:vision-cair.github.io/LongVUGitHub仓库:https://github.com/Vision-CAIR/LongVUHuggingFace模型库:https://huggingface.co/collections/Vision-CAIR/longvu-67181d2debabfc1eb050c21darXiv技术论文:https://arxiv.org/pdf/2410.17434在线体验Demo:https://huggingface.co/spaces/Vision-CAIR/LongVULongVU的应用场景视频内容分析:LongVU用在分析长视频内容,提取关键信息,例如在监控视频、新闻报道或纪录片中识别重要事件和场景。视频搜索和索引:基于理解视频内容,LongVU帮助构建视频搜索引擎,让用户用文本查询快速定位视频中的相关片段。视频内容生成:LongVU用在生成视频内容的描述、总结或字幕,提高视频内容的可访问性和无障碍性。视频问答系统:LongVU支持构建视频问答系统,用户对视频内容提出问题,系统能理解问题、提供准确的答案。教育和培训:在教育领域,LongVU用在分析教学视频,提取关键教学点,帮助学生更好地理解和掌握课程内容。

LongVU的主要功能时空自适应压缩:LongVU基于减少视频标记的数量来处理长视频,保留视频中的关键视觉细节,能在有限的上下文长度内处理非常长的的视频内容。跨模态查询:基于文本引导的跨模态查询来选择性地减少视频帧的特征,能保留与文本查询最相关的帧的详细信息,将其他帧减少到低分辨率的标记表示。帧间依赖性利用:基于分析视频帧之间的时间依赖性,LongVU能基于依赖性执行空间标记的压缩,减少模型的上下文长度需求。长视频理解:LongVU能有效处理1fps采样的视频输入,且能适应性地将每小时长视频的平均每个帧的标记数量减少到2个,适应8k上下文长度的多模态大型语言模型(MLLM)。LongVU的技术原理时间压缩策略:用DINOv2特征识别、去除高度相似的冗余视频帧,减少视频的时间维度上的冗余。选择性特征降低:基于文本引导的跨模态查询,对与文本查询相关的帧保留完整的标记(tokens),对其他帧应用空间池化,减少空间维度上的冗余。空间标记压缩:对于极长的视频,LongVU基于帧之间的时间依赖性进一步压缩空间标记。用计算帧间的空间标记相似性,剔除与首帧相似度过高的后续帧的空间标记,减少模型需要处理的数据量。多模态训练:LongVU结合图像-语言预训练和视频-语言微调,用大规模视频-文本对进行训练,提升模型在视频理解任务中的表现。LongVU的项目地址项目官网:vision-cair.github.io/LongVUGitHub仓库:https://github.com/Vision-CAIR/LongVUHuggingFace模型库:https://huggingface.co/collections/Vision-CAIR/longvu-67181d2debabfc1eb050c21darXiv技术论文:https://arxiv.org/pdf/2410.17434在线体验Demo:https://huggingface.co/spaces/Vision-CAIR/LongVULongVU的应用场景视频内容分析:LongVU用在分析长视频内容,提取关键信息,例如在监控视频、新闻报道或纪录片中识别重要事件和场景。视频搜索和索引:基于理解视频内容,LongVU帮助构建视频搜索引擎,让用户用文本查询快速定位视频中的相关片段。视频内容生成:LongVU用在生成视频内容的描述、总结或字幕,提高视频内容的可访问性和无障碍性。视频问答系统:LongVU支持构建视频问答系统,用户对视频内容提出问题,系统能理解问题、提供准确的答案。教育和培训:在教育领域,LongVU用在分析教学视频,提取关键教学点,帮助学生更好地理解和掌握课程内容。